歴史的瞬間:初の「検証可能な量子優位性」をGoogleが実証

2025年10月22日、 Google Quantum AIチームがNature誌に発表した論文が、量子コンピューティング史における決定的な転換点となった。

同チームは、65量子ビットの超伝導プロセッサ 「Willow」と新開発の「Quantum Echoes」アルゴリズムを組み合わせることで、世界で初めて検証可能な量子優位性(Verifiable Quantum Advantage)を実証した。

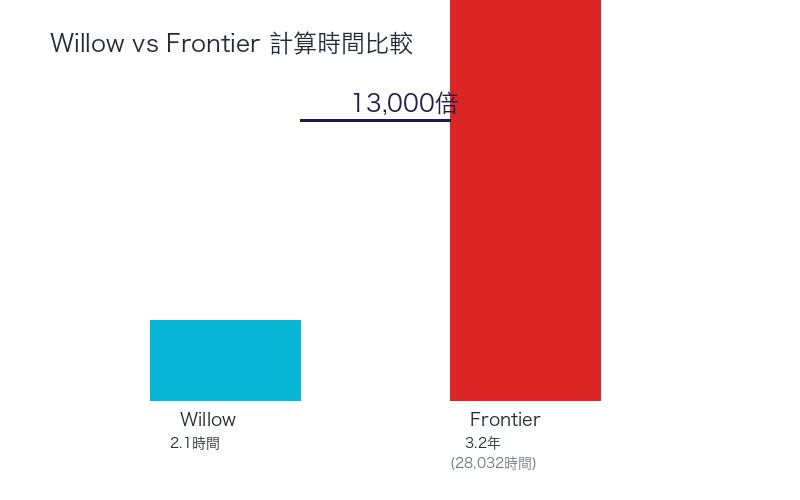

最も衝撃的な数値がこれだ: Willowチップ上でわずか2.1時間で完了した計算が、世界最速のスーパーコンピュータ「Frontier」では3.2年かかる──つまり、13,000倍の速度差である。

しかし、今回の発表が従来の「量子優位性」主張と決定的に異なるのは、 「検証可能性(Verifiability)」という新たな基準を満たしている点だ。量子コンピュータの結果を別の量子コンピュータで再現でき、従来の実験データとも照合可能──これは量子コンピューティングが「実験室の好奇心」から「実用的な科学ツール」へと進化したことを意味する。

Quantum Echoesアルゴリズム──時間を逆行する量子干渉の追跡

「量子エコー」が明かす隠れた情報

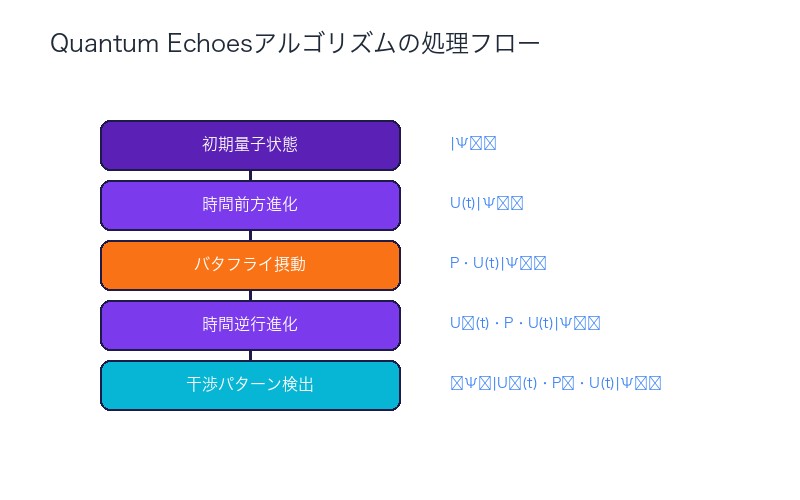

Quantum Echoesアルゴリズムの核心は、 OTOC(Out-of-Time-Order Correlator、時間順序外相関関数)と呼ばれる量子物理学の概念にある。

Google Quantum AI研究者Tom O’Brien氏は、このアルゴリズムの動作を以下のように説明する:

「システムを 時間前方に進化させ、次に小さなバタフライ摂動(butterfly perturbation)を加え、その後時間を逆行させます。前方と後方の進化が干渉し、量子ビット全体に検出可能な波動パターンを生成します。これにより、標準的な観測量では隠れている情報が明らかになります」

このプロセスは、音響学における「エコー」と類似している。音波が壁に反射して戻ってくるように、 量子状態が時間を前後することで「量子エコー」を生成し、システムの深層構造を明らかにする。

OTOC(2)の物理的意味

今回の実験で測定されたのは、 OTOC(2)(二次の時間順序外相関関数)である。これは量子干渉効果を定量化する指標で、以下の物理現象の理解に不可欠とされる:

- 量子カオス:量子システムがどのように情報を拡散させるか

- 量子もつれの成長:粒子間の非局所的相関の進化

- ブラックホール物理:情報喪失パラドックスの解明

- 多体局在:量子システムの熱平衡化メカニズム

従来、OTOC(2)の測定は古典コンピュータでは 指数関数的に困難とされてきた。量子ビット数が増えるごとに計算量が倍増し、40量子ビットを超えるとスーパーコンピュータでも実質的に不可能になる。

Willowチップの技術仕様──65量子ビットの超伝導プロセッサ

ハードウェア性能指標

Willowは、Googleが開発した 65量子ビット超伝導プロセッサで、以下の性能を達成している:

| 性能指標 | Willow実測値 | 意味 |

|---|---|---|

| 2量子ビットゲートエラー率 | 0.15% | 99.85%の精度で2量子ビット操作を実行 |

| システム全体のフィデリティ | 0.001(40回路サイクル時) | 40ステップの計算後も0.1%の精度維持 |

| 信号対雑音比(S/N比) | 2-3(最大システムサイズ) | ノイズの2-3倍の信号強度 |

| 実験実行時間 | 2.1時間(キャリブレーション含む) | Frontier スパコンなら3.2年相当 |

超伝導技術の優位性

Willowは 超伝導量子ビット(superconducting qubits)を使用している。この技術の利点は:

- 制御性:マイクロ波パルスで精密に量子状態を操作可能

- 拡張性:既存の半導体製造技術を活用できる

- 高速動作:ゲート操作時間がナノ秒オーダー

- 統合性:複数の量子ビットを1チップに集積可能

ただし、超伝導量子ビットは 絶対零度近く(約15ミリケルビン)で動作させる必要があり、希釈冷凍機という特殊な冷却装置が不可欠である。

13,000倍の速度差──Frontierスーパーコンピュータとの比較

実験の具体的内容

今回の実験では、以下の計算を実行した:

- 問題:65量子ビットシステムのOTOC(2)測定

- Willow実行時間:2.1時間(126分)

- Frontier推定時間:3.2年(約28,032時間)

- 速度比:28,032 ÷ 126 ≒ 13,000倍

Frontierスーパーコンピュータとは

Frontierは、米国オークリッジ国立研究所(ORNL)が運用する世界最速のスーパーコンピュータである(2025年時点)。

- 性能:1.1エクサフロップス(1.1×10^18 FLOPS)

- プロセッサ:AMD EPYC + AMD Instinct GPUの組み合わせ

- ノード数:9,408ノード

- 消費電力:約29メガワット

それでも、 Frontierの膨大な計算能力を持ってしても、Willowが2時間で解く問題に3年以上かかる。これは量子力学の「状態空間の爆発」問題による。

古典コンピュータは量子ビット数nに対して 2^n個の振幅を追跡する必要があるが、量子コンピュータはn個の量子ビットで直接計算できる。65量子ビットの場合、2^65 ≒ 3.7×10^19の状態を追跡しなければならず、これが古典計算の限界を示している。

「検証可能性」の革新性──従来の量子優位性との違い

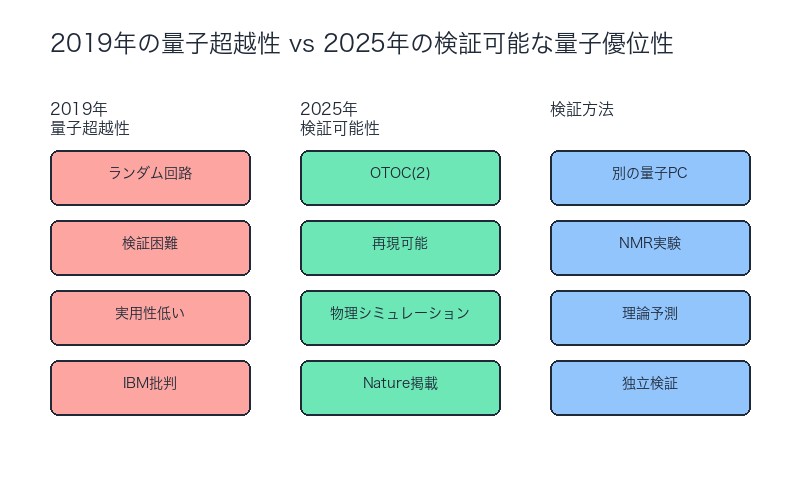

2019年のGoogleの量子優位性主張との比較

Googleは2019年にも「量子超越性(Quantum Supremacy)」を主張したが、当時は以下の批判を受けた:

- 実用性の欠如:ランダム回路サンプリングという「無意味な計算」

- 検証困難性:結果が正しいか古典的に検証できない

- IBMの反論:改良されたアルゴリズムなら古典コンピュータでも数日で計算可能

今回の「検証可能な量子優位性」の3つの基準

Google Quantum AIのVice President、 Hartmut Neven氏は、今回の成果が以下の基準を満たすと説明する:

- 再現可能性:同等の量子コンピュータで同じ結果を得られる

- 実験的検証:核磁気共鳴(NMR)などの従来実験と照合可能

- 理論的予測:既知の物理法則から予測される結果と一致

懐疑的な声も──Dries Sels氏の指摘

ニューヨーク大学(NYU)の量子物理学者 Dries Sels氏は、慎重な姿勢を示している。

「量子優位性を主張する際の 証明のハードルは高くあるべきです。過去の主張の多くが、後により効率的な古典アルゴリズムによって覆されてきました」

Sels氏は、以下の点を検証すべきだと主張する:

- 古典アルゴリズムの最適化余地はないか

- 量子コンピュータの結果の統計的有意性

- エラー率が結果に与える影響の定量化

- 独立した研究チームによる再現実験

UC Berkeley共同研究──分子シミュレーションへの応用

15原子・28原子分子の構造解析

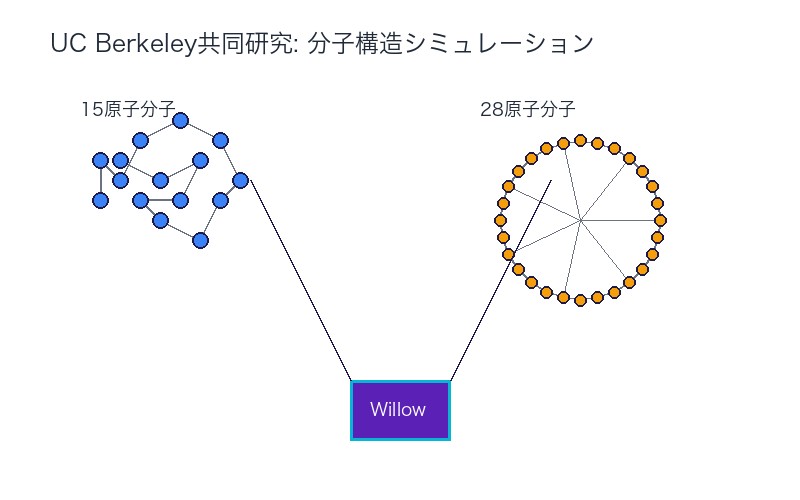

Google Quantum AIは、 カリフォルニア大学バークレー校(UC Berkeley)と共同で、Quantum Echoesアルゴリズムの実証実験を行った。

実験では、以下の2つの分子を対象とした:

- 15原子分子:比較的小規模な有機分子

- 28原子分子:より複雑な分子構造

結果は従来の 核磁気共鳴(NMR)分光法の測定値と一致し、さらにNMRでは通常得られない情報も明らかになった。

NMRを超える情報取得

従来のNMR分光法は、分子の以下の情報を提供する:

- 原子核の種類と数

- 化学結合の存在

- 分子の対称性

しかし、Quantum Echoesアルゴリズムは、 量子干渉パターンを追跡することで、NMRでは検出できない微細な構造情報を明らかにできる可能性がある。具体的には:

- 量子もつれの空間分布:どの原子間に強い相関があるか

- 動的な構造変化:分子の振動や回転の詳細

- 励起状態の寿命:エネルギーの散逸メカニズム

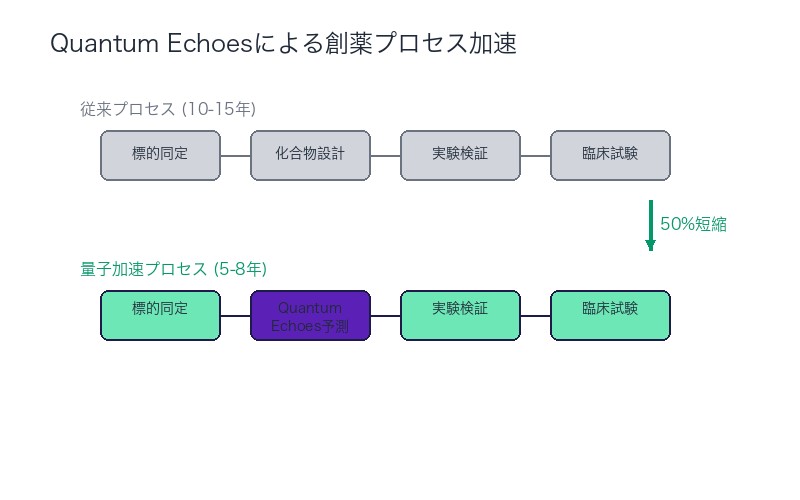

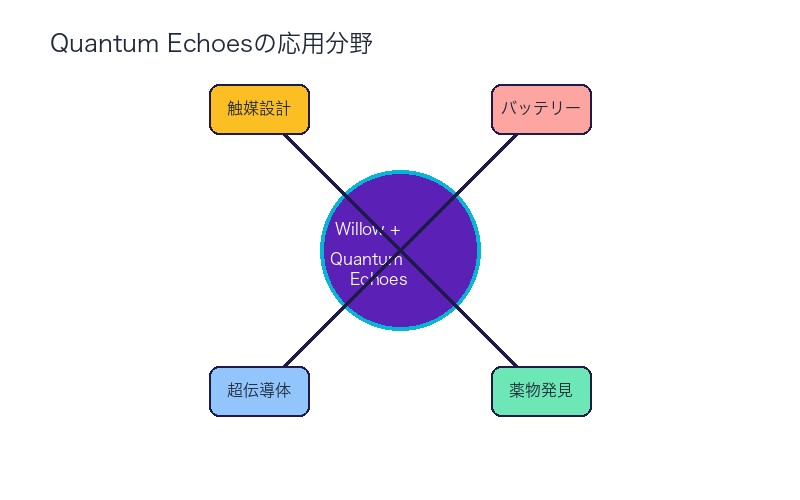

薬物発見への応用──タンパク質結合予測の革新

創薬プロセスのボトルネック

現在の創薬研究では、以下のプロセスに膨大な時間とコストがかかる:

| ステップ | 従来の方法 | 所要時間 | 成功率 |

|---|---|---|---|

| 標的タンパク質の同定 | 実験的スクリーニング | 1-2年 | 低い |

| 候補化合物の設計 | 計算化学シミュレーション | 6ヶ月-1年 | 中程度 |

| 結合親和性の測定 | in vitro実験 | 3-6ヶ月 | 高い |

| 薬効・毒性試験 | 動物実験・臨床試験 | 5-10年 | 極めて低い |

特に問題なのは、 候補化合物が標的タンパク質にどのように結合するかを予測する段階である。従来の分子動力学シミュレーションは、以下の限界がある:

- 計算量の爆発:原子数が増えると指数関数的に困難に

- 近似の粗さ:量子効果を無視した古典力学モデル

- 時間スケールの制約:ミリ秒以上の現象を追跡できない

量子コンピュータによる創薬加速

Quantum Echoesアルゴリズムは、以下の創薬プロセスを革新する可能性がある:

- タンパク質-リガンド結合の量子シミュレーション:薬物候補分子がタンパク質の活性部位にどのように結合するかを量子力学的に正確に予測

- 電子状態の精密計算:化学結合の形成・切断を量子レベルで追跡

- 動的結合過程の解明:結合の「過程」を時間発展として観測

- スクリーニング効率の向上:数百万の候補化合物を高速評価

具体的な応用例:抗がん剤開発

例えば、 キナーゼ阻害剤(抗がん剤の一種)の開発では、以下の課題がある:

- 標的キナーゼへの選択的結合:他の類似タンパク質には結合しない

- 薬物耐性の回避:がん細胞が変異しても効果を維持

- 副作用の最小化:正常細胞への影響を抑制

Quantum Echoesアルゴリズムは、 キナーゼと阻害剤候補の量子干渉パターンを計算することで、上記の特性を予測できる可能性がある。これにより、実験に進む前に最適な候補化合物を絞り込める。

材料科学への応用──次世代材料の設計

超伝導体・触媒の分子構造解明

Quantum Echoesアルゴリズムは、創薬以外にも以下の材料科学分野で応用が期待される:

- 高温超伝導体:室温超伝導を実現する材料の探索

- 触媒材料:化学反応を効率化する触媒の設計

- バッテリー材料:エネルギー密度の高い電池の開発

- 太陽電池:光吸収効率の最適化

触媒設計の具体例:アンモニア合成

アンモニア合成(ハーバー・ボッシュ法)は、世界のエネルギー消費の約1-2%を占める重要な化学プロセスである。しかし、以下の課題がある:

- 高温高圧条件:400-500℃、200-300気圧が必要

- エネルギー浪費:CO2排出量が膨大

- 触媒の限界:鉄系触媒の効率は理論限界に近い

Quantum Echoesアルゴリズムで 窒素分子(N₂)の解離過程を量子レベルでシミュレーションできれば、室温・低圧で動作する革新的触媒を設計できる可能性がある。

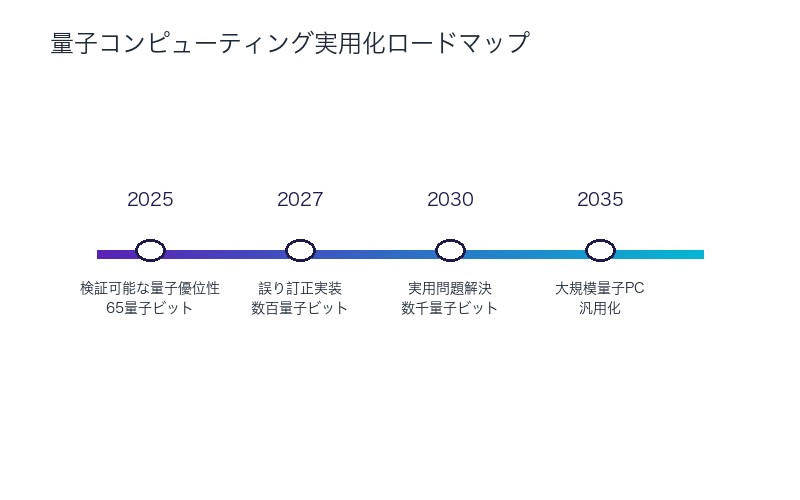

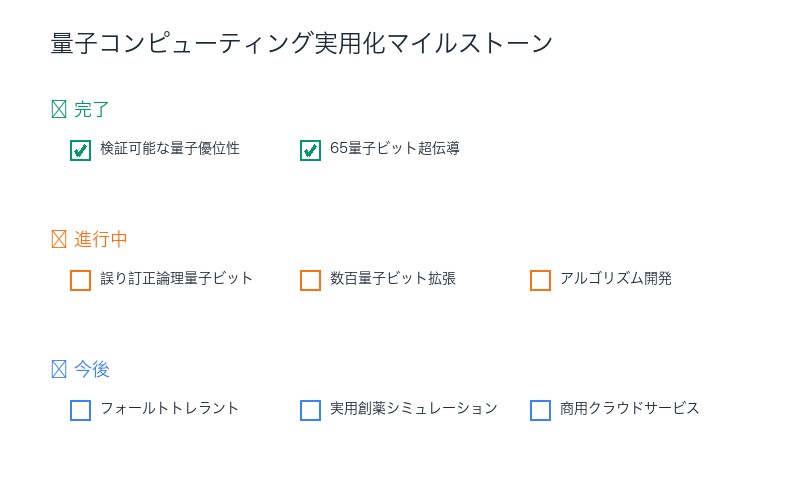

量子コンピューティングの現在地──実用化までの課題

依然として存在する技術的障壁

今回の成果は画期的だが、量子コンピュータが古典コンピュータを完全に置き換えるにはまだ時間がかかる。主な課題は:

- エラー訂正:現在のエラー率(0.15%)では大規模計算は困難

- 量子ビット数:実用的問題には数千~数百万量子ビットが必要

- コヒーレンス時間:量子状態を長時間維持できない

- 冷却技術:15ミリケルビンの極低温維持にはコストがかかる

- アルゴリズム開発:実用問題に適用できるアルゴリズムが限定的

Googleの次の目標:誤り訂正量子コンピュータ

Hartmut Neven氏は、次の大きな目標として 「フォールトトレラント量子コンピュータ(誤り訂正量子コンピュータ)」を掲げている。

これは、 物理量子ビットを複数組み合わせて論理量子ビットを構成し、エラーを自動的に訂正する技術である。現在の研究では、1つの論理量子ビットに約1,000個の物理量子ビットが必要とされる。

つまり、 実用的な量子コンピュータには数百万の物理量子ビットが必要であり、Willowの65量子ビットからは大きな隔たりがある。

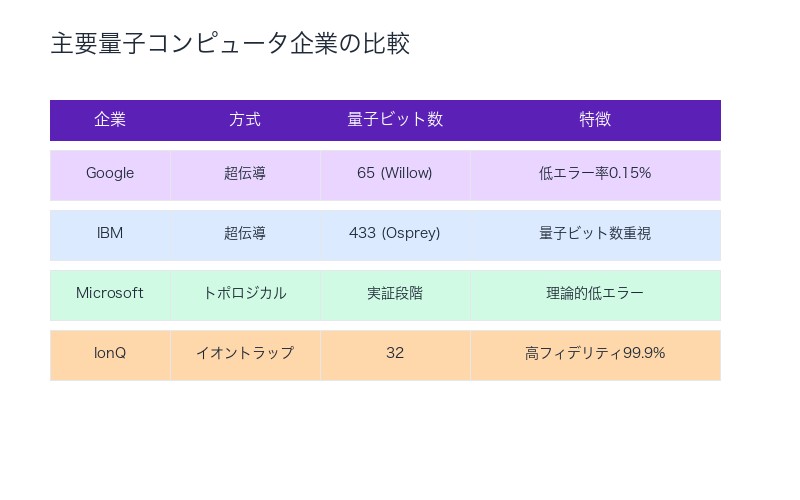

競合他社の動向──IBM・Microsoft・IonQの戦略

IBM: 量子ビット数重視のアプローチ

IBMは2023年に 433量子ビットの「Osprey」プロセッサを発表し、2025年には1,000量子ビット超の「Condor」を計画している。

IBMの戦略は、 量子ビット数を増やすことで実用的問題を解ける規模を目指すことである。ただし、エラー率がGoogleより高いという批判もある。

Microsoft: トポロジカル量子ビット研究

Microsoftは、 トポロジカル量子ビットという異なるアプローチを追求している。これは理論的にはエラー率が極めて低いが、実証には至っていない。

IonQ: イオントラップ技術

IonQは、 イオントラップ方式で高いフィデリティ(>99.9%)を達成している。超伝導方式より量子ビット数は少ないが、精度では優位性がある。

まとめ:量子コンピューティングの新時代の幕開け

今回の発表が意味する3つの歴史的転換点

- 検証可能性の確立:量子優位性が再現可能・検証可能になった初の事例

- 実用問題への適用:物理シミュレーション・創薬など実用的価値のある計算を実現

- 理論と実験の融合:量子物理学の予測を量子コンピュータで検証できるツールの誕生

2030年代の量子コンピューティング予測

今回の成果を踏まえ、以下のシナリオが現実味を帯びてきた:

- 2027-2028年:誤り訂正機能を持つ論理量子ビットの実証

- 2030年:創薬・材料科学で実用的な量子シミュレーションが可能に

- 2032-2035年:特定分野(暗号解読、最適化問題)で量子コンピュータが古典を凌駕

- 2040年:汎用量子コンピュータの商用化

産業界・学術界への影響

今回の発表は、以下の業界に大きな影響を与える:

| 業界 | 短期的影響(1-3年) | 長期的影響(5-10年) |

|---|---|---|

| 製薬 | 量子シミュレーション研究への投資加速 | 創薬期間の半減、開発コスト削減 |

| 化学 | 触媒・材料研究での量子計算導入 | 革新的触媒・超伝導体の発見 |

| 金融 | ポートフォリオ最適化への応用研究 | リスク評価の精度向上 |

| AI | 量子機械学習アルゴリズム開発 | 古典AIを超える学習能力 |

| セキュリティ | 量子耐性暗号への移行開始 | 現在の暗号技術の陳腐化 |

日本の量子コンピューティング戦略への示唆

日本は、 量子技術イノベーション戦略(2020年策定)で量子コンピューティングを重点分野に位置づけている。今回のGoogleの成果は、以下の教訓を示している:

- ハードウェア開発への継続投資:超伝導・イオントラップ両方のアプローチを推進

- アルゴリズム研究の強化:実用問題に適用できるアルゴリズム開発が鍵

- 産学連携の加速:UC Berkeleyのような大学との共同研究体制

- 人材育成:量子物理学・量子情報科学の専門家養成

理化学研究所(RIKEN)、東京大学、NTT、富士通などが量子コンピュータ研究を進めており、 2030年までに実用的な量子コンピュータの実現を目指している。

最後に──「量子の時代」は本当に来るのか

Googleの今回の発表は、量子コンピューティングが「夢物語」から「実現可能な技術」へと移行したことを示している。

しかし、懐疑論者が指摘するように、 「量子優位性」と「実用的な量子コンピュータ」の間には大きな隔たりがある。65量子ビットから数百万量子ビットへのスケーリングは、単なる技術的課題ではなく、物理学・工学・材料科学の総合的なブレークスルーを必要とする。

それでも、Quantum Echoesアルゴリズムが示した「検証可能性」という新たな基準は、量子コンピューティングが科学的手法として成熟しつつあることを証明している。

2025年10月22日──この日は、後世から振り返ったとき、 「量子コンピューティングが実用化に向けて本格的に動き出した転換点」として記憶されるかもしれない。

コメント