2025年11月6日、中国のスタートアップMoonshot AIが発表した「Kimi K2 Thinking」が、AI業界に衝撃を与えています。OpenAIのGPT-5やAnthropicのClaude 4.5 Sonnetを上回るベンチマーク結果を記録しながら、トレーニングコストはわずか460万ドル。しかも完全なオープンソースとして無料で公開されています。

🚀 Kimi K2 Thinking 主要スペック

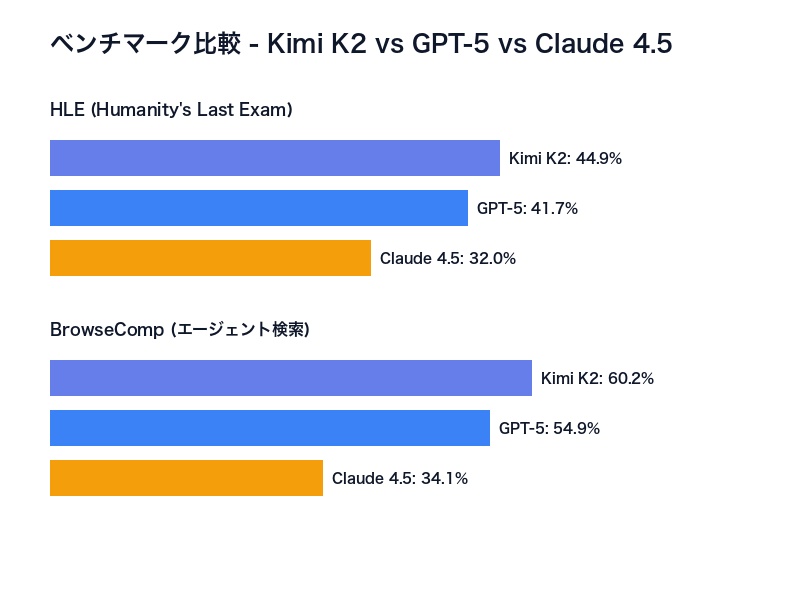

- HLE:44.9%(GPT-5: 41.7%、Claude 4.5: 32.0%)

- BrowseComp:60.2%(GPT-5: 54.9%、Claude 4.5: 24.1-34.1%)

- 総パラメータ:1兆(アクティブ32B、MoE構造)

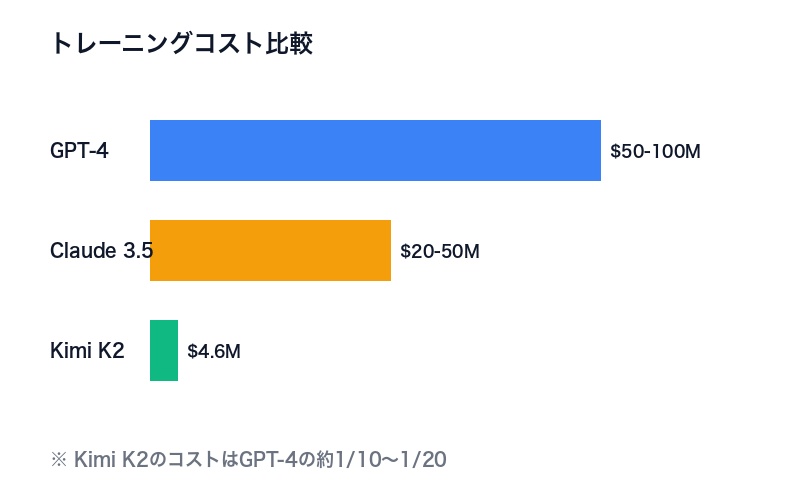

- トレーニングコスト:460万ドル(GPT-4の1/10〜1/20)

- 連続ツール実行:200-300回(人間の介入なし)

- コンテキスト長:256Kトークン

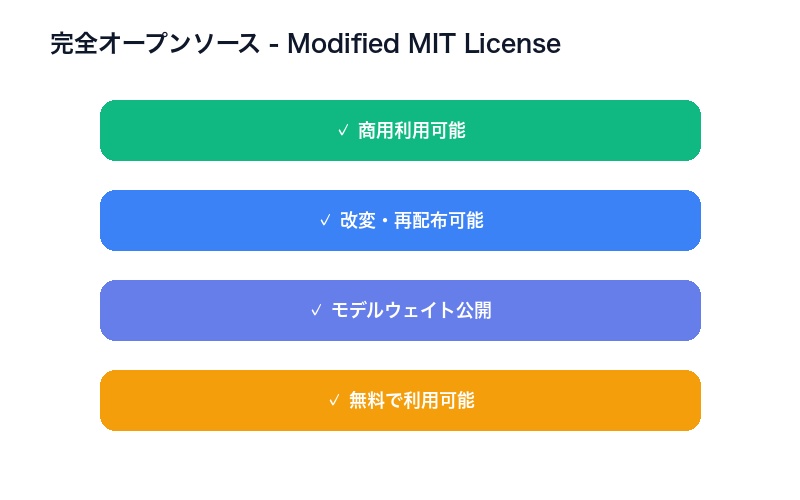

- ライセンス:Modified MIT(オープンソース)

この記事では、Kimi K2 Thinkingの驚異的な性能、破格のコスト効率、そして中国AI産業の急速な台頭が世界のAI市場に与える影響について徹底解説します。

Kimi K2 Thinkingとは? – Moonshot AIの最新作

Kimi K2 Thinkingは、中国のAIスタートアップMoonshot AI(月之暗面)が2025年11月6日に発表した大規模言語モデルです。同社が7月に発表した「Kimi K2」の推論特化版として開発され、推論能力とツール連携機能が大幅に強化されています。

Moonshot AIの背景

Moonshot AIは、2023年に設立された中国の新興AI企業で、Alibaba Groupなどから出資を受けています。創業からわずか2年で、世界トップクラスのAIモデルを開発する企業に成長しました。

設立年:2023年 主要投資家:Alibaba Group、その他VC 代表モデル:Kimi K2シリーズ、Kimi K2 Thinking 特徴:長文脈処理(256K)、エージェント機能、推論能力

Kimi K2とK2 Thinkingの違い

| 項目 | Kimi K2 | Kimi K2 Thinking |

|---|---|---|

| リリース日 | 2025年7月 | 2025年11月6日 |

| 主要機能 | 汎用LLM | 推論特化 + エージェント機能 |

| 総パラメータ | 非公開 | 1兆(1T) |

| アクティブパラメータ | 非公開 | 32B(MoE構造) |

| 連続ツール実行 | 限定的 | 200-300回 |

| ベンチマーク | 非公開 | HLE 44.9%、BrowseComp 60.2% |

| 量子化 | 標準 | ネイティブINT4 |

K2 Thinkingは推論とエージェント機能に特化することで、OpenAIのo1シリーズやAnthropicのClaude 4.5 Sonnetと同じカテゴリに位置づけられます。

驚異のベンチマーク結果 – GPT-5、Claude 4.5を上回る

Kimi K2 Thinkingは、複数の重要なベンチマークでGPT-5とClaude 4.5 Sonnetを上回る結果を記録しました。

HLE(Humanity’s Last Exam)- 44.9%でトップ

HLE(人類最後の試験)は、AIの高度な推論能力を測定する最も難易度の高いベンチマークの1つです。Kimi K2 Thinkingは、このテストで44.9%のスコアを獲得しました。

| モデル | HLEスコア(ツールあり) |

|---|---|

| Kimi K2 Thinking | 44.9% |

| GPT-5 | 41.7% |

| Claude 4.5 Sonnet | 32.0% |

| Kimi K2 Thinking(Heavy Mode) | 51.0% |

Heavy Modeでは8つの並列軌道を実行して結果を集約することで、51.0%という驚異的なスコアを達成しています。

BrowseComp – 60.2%で人間の2倍

BrowseCompは、エージェントが実際のWebブラウジングと情報検索を行う能力を測定します。人間のベースラインは29.2%ですが、Kimi K2 Thinkingは60.2%を達成しました。

| モデル | BrowseCompスコア |

|---|---|

| Kimi K2 Thinking | 60.2% |

| GPT-5 | 54.9% |

| Claude 4.5 Sonnet | 24.1% – 34.1% |

| 人間ベースライン | 29.2% |

その他のベンチマーク結果

Tau-2 Bench Telecom(エージェントツール使用) 独立評価機関Artificial Analysisによる測定で、93%を記録。同機関が「これまで測定した中で最高スコア」と評価しています。

SWE-Bench Verified(コーディング能力) ソフトウェアエンジニアリングの実問題を解決する能力を測定するベンチマークで、71.3%を達成。GPT-5と同等の性能です。

破格のトレーニングコスト – わずか460万ドル

Kimi K2 Thinkingの最も衝撃的な特徴の1つが、そのトレーニングコストの低さです。

460万ドルという破格の数字

Moonshot AIの関係者によると、Kimi K2 Thinkingのトレーニングコストはわずか460万ドル(約6億9000万円)です。

これは以下と比較すると驚異的な数字です:

| モデル | 推定トレーニングコスト |

|---|---|

| GPT-4 | 5000万〜1億ドル(推定) |

| Claude 3.5 | 数千万ドル(推定) |

| Kimi K2 Thinking | 460万ドル |

| Gemini Ultra | 数千万ドル(推定) |

GPT-4のコストの1/10〜1/20という圧倒的なコスト効率を実現しています。

低コストを実現する技術

Kimi K2 Thinkingが低コストを実現できた理由:

-

MoE(Mixture-of-Experts)アーキテクチャ

- 総パラメータ1兆のうち、推論時に使用するのは32Bのみ

- 計算コストを大幅に削減

-

ネイティブINT4量子化

- 推論時の計算量とメモリ使用量を約半分に削減

- 性能劣化なしで高速化を実現

-

効率的なトレーニング手法

- 中国のGPUインフラと電力コストの優位性

- 最適化されたトレーニングパイプライン

-

オープンソース戦略

- 基礎研究の成果を活用

- コミュニティによる改善を期待

この低コストモデルは、AI開発の民主化において重要な意味を持ちます。

技術仕様 – 1兆パラメータの実力

Kimi K2 Thinkingの技術的な特徴を詳しく見ていきましょう。

パラメータ構成

総パラメータ数:1兆(1T = 1,000B) アクティブパラメータ数:320億(32B) アーキテクチャ:MoE(Mixture-of-Experts)

MoE構造により、1兆パラメータの知識を保持しながら、推論時には32Bのパラメータのみを使用します。これにより:

- 低遅延:小型モデル並みの推論速度

- 高性能:大型モデル並みの精度

- 低コスト:計算リソースの最適化

コンテキスト長 – 256Kトークン

Kimi K2 Thinkingは256,000トークンのコンテキストウィンドウをサポートします。

参考比較:

- GPT-4 Turbo:128K

- Claude 3.5 Sonnet:200K

- Kimi K2 Thinking:256K

- Gemini 1.5 Pro:1M(ただし実用性に課題)

256Kトークンは、約384,000文字(日本語)、または約500ページの文書に相当します。

ネイティブINT4量子化

通常、LLMは32ビット浮動小数点(FP32)または16ビット(FP16/BF16)で動作しますが、Kimi K2 ThinkingはネイティブINT4量子化で設計されています。

INT4量子化の利点:

- 推論速度が約2倍に向上

- メモリ使用量が1/2〜1/4に削減

- 性能劣化がほぼゼロ(ネイティブ設計のため)

これにより、Macなどのコンシューマーハードウェアでもローカル実行が可能になります(ただし32Bでも要求は高め)。

サポート言語

Kimi K2 Thinkingは、リリース時点から以下の言語をネイティブサポート:

- 日本語 🇯🇵

- 英語 🇺🇸

- 中国語(簡体字・繁体字) 🇨🇳

日本語の性能は、GPT-4やClaude 3.5と同等またはそれ以上との評価もあります。

驚異のエージェント機能 – 300回連続ツール実行

Kimi K2 Thinkingの最も革新的な特徴の1つが、その自律型エージェント機能です。

200-300回連続ツール呼び出し

Kimi K2 Thinkingは、人間の介入なしで200〜300回の連続したツール呼び出しを実行できます。これは:

- GPT-4 Turbo:約10-20回の連続呼び出しで精度低下

- Claude 3.5 Sonnet:約30-50回が実用的な上限

- Kimi K2 Thinking:200-300回を一貫した推論で実行

実際のユースケース

この能力により、以下のような複雑なタスクを完全自律で実行できます:

-

複雑なリサーチタスク

- 複数のWebサイトを横断して情報収集

- データの整理、比較、分析

- レポート作成まで自動化

-

ソフトウェア開発タスク

- コードベース全体の分析

- バグの特定と修正案の提示

- テストコードの自動生成

-

データ分析パイプライン

- データ収集 → クリーニング → 分析 → 可視化

- 中間結果を検証しながら次のステップへ進行

-

マルチステップ問題解決

- 数学的証明や複雑な論理パズル

- 複数の検索と推論を組み合わせた回答生成

エージェントの信頼性

従来のLLMエージェントは、ツール呼び出しが増えるにつれて:

- 指示からの逸脱

- エラーの蓄積

- 無限ループの発生

などの問題が発生しましたが、Kimi K2 Thinkingは300ステップにわたって一貫した推論を維持できることが確認されています。

オープンソースの革命 – 無料で利用可能

Kimi K2 Thinkingは、完全なオープンウェイトモデルとして公開されています。

Modified MIT License

Kimi K2 ThinkingはModified MIT Licenseで公開されています。これは:

- 商用利用可能:企業での利用も無料

- 改変・再配布可能:モデルの改良と共有が自由

- 帰属表示のみ必要:Moonshot AIのクレジット表記のみ

ただし、標準のMITライセンスから若干の修正が加えられており、一部の悪用を防ぐ制約が設けられています。

公開されているもの

-

モデルウェイト(Hugging Faceで公開)

- 完全な1兆パラメータのウェイト

- INT4量子化済みバージョン

-

アーキテクチャ情報

- モデル構造の詳細

- MoEの設定パラメータ

-

APIアクセス

- kimi.com経由で無料利用

- 無制限(公正利用規約内)

-

ドキュメント

- 技術仕様書

- ベンチマーク結果

- 使用例

Hugging Faceでの公開

Kimi K2 Thinkingは、Hugging Faceの公式リポジトリで公開されています:

リポジトリ:moonshotai/Kimi-K2-Thinking

ダウンロードサイズ:約400GB(INT4量子化版)

必要VRAM:最低80GB(推論)、推奨120GB以上

無料Web版の提供

最も手軽にKimi K2 Thinkingを試す方法は、公式サイトです:

URL:https://kimi.com/ 料金:完全無料 制限:なし(公正利用の範囲内) 言語:日本語、英語、中国語

アカウント登録だけで、すぐに使い始められます。

中国AIの快進撃が止まらない

Kimi K2 Thinkingは、中国AI産業の急速な成長を象徴する存在です。

中国発の主要オープンソースLLM

2023年以降、中国から多数の高性能オープンソースLLMが登場しています:

| モデル | 開発元 | パラメータ | 特徴 |

|---|---|---|---|

| Qwen 2.5 | Alibaba | 最大72B | 多言語、長文脈 |

| DeepSeek V3 | DeepSeek | 671B(MoE) | 推論特化 |

| Yi-34B | 01.AI | 34B | 高性能汎用 |

| Baichuan 2 | Baichuan AI | 最大13B | 中国語特化 |

| ChatGLM 3 | Zhipu AI | 最大130B | 対話特化 |

| Kimi K2 Thinking | Moonshot AI | 1T(32B active) | エージェント、推論 |

中国AIの強み

中国のAI産業が急速に成長している理由:

-

豊富な人材プール

- 世界最多のAI研究者

- 欧米の大学で訓練された人材の帰国

-

低コストのインフラ

- 安価な電力コスト

- 大規模GPUクラスターへのアクセス

- 国家レベルのAI投資

-

オープンソース文化

- 研究成果の迅速な公開

- コミュニティによる改善サイクル

-

規制環境

- AI開発への政府支援

- データアクセスの柔軟性

- 実験的な試みへの寛容さ

西側との性能ギャップ縮小

2023年時点では、中国のLLMは欧米のトップモデルに1-2世代遅れていると言われていました。しかし:

- 2024年半ば:DeepSeek V2がGPT-4に匹敵する性能

- 2024年後半:Qwen 2.5がClaude 3.5と同等に

- 2025年11月:Kimi K2 ThinkingがGPT-5を超える

わずか2年でギャップが逆転しました。

コスト競争力の衝撃

中国モデルの最大の強みは、圧倒的なコスト効率です:

| モデル | トレーニングコスト | 推論コスト(1Mトークン) |

|---|---|---|

| GPT-4 | 5000万〜1億ドル | $30-60 |

| Claude 3.5 | 数千万ドル | $15-30 |

| Gemini Ultra | 数千万ドル | $20-40 |

| Kimi K2 Thinking | 460万ドル | 無料 |

| DeepSeek V3 | 約1000万ドル | $0.50-2 |

推論コストが10分の1以下というコスト競争力は、AI市場に革命的な変化をもたらす可能性があります。

日本へのインパクトと示唆

Kimi K2 Thinkingの登場は、日本のAI戦略に重要な示唆を与えます。

国産LLM開発戦略の再考

日本政府は、国産LLMの開発に数百億円規模の予算を投入していますが、Kimi K2 Thinkingの登場はこの戦略に疑問を投げかけます:

従来の日本の戦略:

- ゼロから独自のLLMを開発

- 投資額:数百億〜数千億円

- 開発期間:3-5年

- 目標:GPT-4レベルの性能

Kimi K2 Thinkingが示す選択肢:

- 高性能オープンソースモデルをベースに

- 日本語と日本文化への最適化に集中

- 安全性テストと検証に予算を投入

- ホスティングインフラの整備

コスト比較:

- 独自開発:500億〜数千億円

- オープンソース活用:50億〜100億円(1/10以下)

Anthropic CEOの指摘との整合性

AnthropicのCEO Dario Amodeiは、「世界最高峰のAIモデルを開発できるのは5社程度」と述べています:

- OpenAI(米国)

- Anthropic(米国)

- Google(米国)

- Meta(米国)

- DeepMind/Google(英国)

これに加えて、中国勢(Moonshot AI、DeepSeek、Alibaba)が台頭しています。

必要な投資額:

- 次世代モデル開発:1兆円以上

- GPUクラスター:数千億円

- 年間運用コスト:数百億円

日本がこの競争に独力で参入するのは現実的ではありません。

現実的な日本のAI戦略

Kimi K2 Thinkingのような高性能オープンソースモデルの登場により、日本は以下の戦略を検討すべきです:

-

オープンソースモデルの活用

- Kimi K2、Qwen、DeepSeek等をベースに

- 日本語性能の向上に集中投資

-

安全性とセキュリティの確保

- バックドアやバイアスの検証

- 独立した評価機関の設立

-

ホスティングインフラの整備

- 国内でのモデル展開

- データ主権の確保

-

特定ドメインへの特化

- 医療、法律、金融など

- 日本特有の領域でのファインチューニング

-

産学連携の強化

- 大学・研究機関との協力

- 実用化への橋渡し

この戦略により、予算を1/10に抑えながら、より早く実用化できる可能性があります。

セキュリティ上の懸念

ただし、中国製オープンソースモデルを使用する際の懸念も存在します:

潜在的なリスク:

- データの中国への流出

- バックドアの存在

- 政治的バイアス

- サプライチェーン攻撃

対策:

- 完全なローカルホスティング

- モデルの徹底的な検証

- センシティブ情報の取り扱いルール

- 複数モデルの併用によるリスク分散

OSSモデルは完全にウェイトが公開されているため、バイナリブラックボックスよりも検証しやすいという利点もあります。

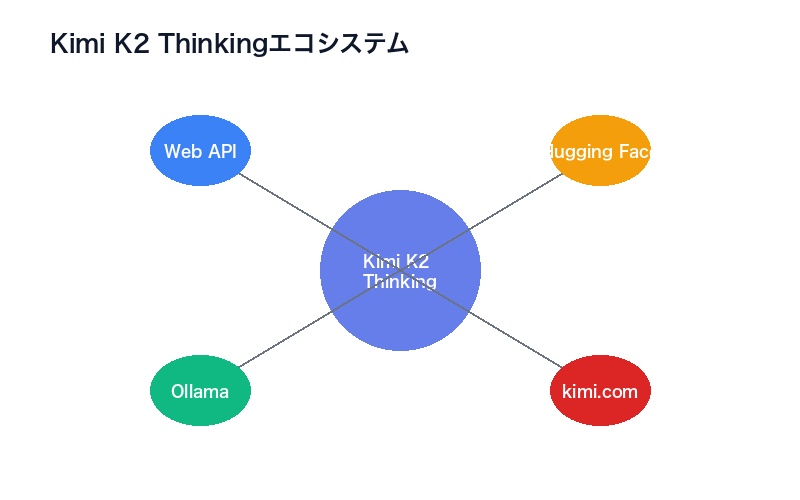

使い方とアクセス方法

Kimi K2 Thinkingを実際に使用する方法をご紹介します。

1. Kimi.com(最も簡単)

手順:

- kimi.comにアクセス

- メールアドレスまたはSNSアカウントで登録

- すぐにチャット開始可能

特徴:

- 完全無料、無制限

- 日本語完全対応

- Webブラウザから即利用

- インストール不要

2. Hugging Face(開発者向け)

リポジトリ:moonshotai/Kimi-K2-Thinking

手順:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained(

"moonshotai/Kimi-K2-Thinking",

device_map="auto",

trust_remote_code=True

)

tokenizer = AutoTokenizer.from_pretrained("moonshotai/Kimi-K2-Thinking")

# 推論

inputs = tokenizer("あなたの質問", return_tensors="pt")

outputs = model.generate(**inputs, max_length=2048)

print(tokenizer.decode(outputs[0]))必要環境:

- Python 3.8以上

- PyTorch 2.0以上

- VRAM 80GB以上(推論)

- ストレージ 400GB以上

3. Ollama(ローカル実行)

インストール:

# Ollamaのインストール(Mac/Linux)

curl -fsSL https://ollama.com/install.sh | sh

# Kimi K2 Thinkingのダウンロードと実行

ollama run kimi-k2-thinkingチャット:

>>> 量子コンピュータの仕組みを教えてください注意点:

- M1 Max以上のMacを推奨

- 64GB以上のRAMが必要

- ダウンロードに時間がかかる(約400GB)

4. API経由(プログラマティックアクセス)

Moonshot AIは、開発者向けにAPIも提供しています。

エンドポイント:https://api.moonshot.cn/v1/

認証:APIキー(kimi.comで発行)

料金:無料プラン・有料プランあり

Python例:

import requests

api_key = "your_api_key"

url = "https://api.moonshot.cn/v1/chat/completions"

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

data = {

"model": "kimi-k2-thinking",

"messages": [

{"role": "user", "content": "日本のGDP成長率を過去10年分調査して"}

],

"temperature": 0.7

}

response = requests.post(url, headers=headers, json=data)

print(response.json())どの方法を選ぶべきか

| 用途 | 推奨方法 | 理由 |

|---|---|---|

| 気軽に試す | kimi.com | 無料、簡単、日本語対応 |

| プロダクション統合 | API | 安定性、サポート、スケール |

| 研究・開発 | Hugging Face | 完全制御、カスタマイズ可能 |

| プライバシー重視 | Ollama | 完全ローカル、データ流出なし |

| 低スペック環境 | API | サーバー側で処理 |

初めて試す場合は、kimi.comが最も手軽でおすすめです。

まとめ – AI民主化の新時代

Kimi K2 Thinkingの登場は、AI業界に3つの重要なメッセージを送っています。

1. 性能の壁が崩れた

中国製オープンソースモデルが、OpenAIやAnthropicのトップモデルを上回る性能を達成。技術的な優位性は一時的なものであることが証明されました。

重要な数字:

- HLE 44.9%(GPT-5: 41.7%)

- BrowseComp 60.2%(GPT-5: 54.9%)

- トレーニングコスト 460万ドル(GPT-4の1/10〜1/20)

2. オープンソースが勝利する

完全なオープンウェイト、無料提供という戦略により、Kimi K2 Thinkingは急速に普及する可能性があります。クローズドソースの優位性は消滅しつつあります。

3. AI民主化が加速

高性能モデルへのアクセスが無料化・民主化されることで:

- 個人開発者でも世界最高峰のAIを利用可能

- スタートアップの参入障壁が劇的に低下

- 途上国でもAI技術の活用が進む

日本への提言

日本は、この変化に素早く適応する必要があります:

-

独自開発から戦略的活用へ

- ゼロからの開発ではなく、OSSの活用

- 日本語最適化と安全性検証に集中

-

産業応用の加速

- 医療、法律、金融などへの適用

- 実用化スピードの向上

-

セキュリティ体制の整備

- モデル検証の仕組み構築

- データ主権の確保

試してみよう

Kimi K2 Thinkingは、今すぐ無料で試すことができます。

今すぐアクセス:https://kimi.com/

GPT-5やClaude 4.5を超える性能を、あなた自身の目で確かめてください。AI技術の新時代が、すでに始まっています。

コメント