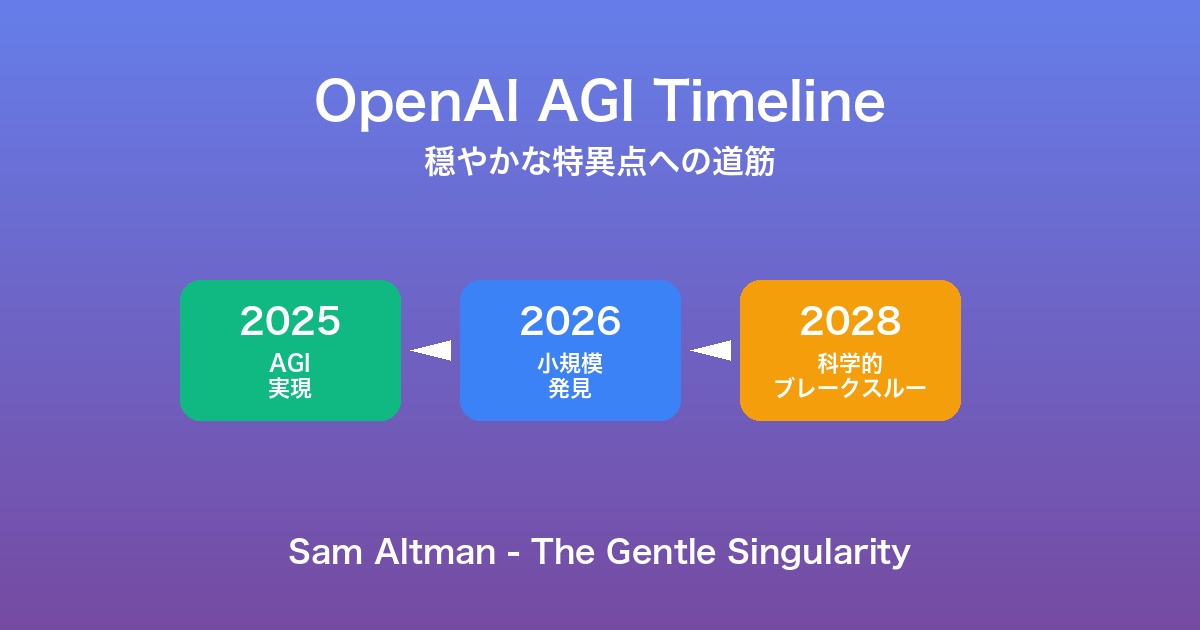

2025年、OpenAIのCEO Sam Altmanが発表した一連の声明が、AI業界に大きな衝撃を与えています。「私たちはAGI(汎用人工知能)の構築方法を知っている」「event horizon(事象の地平線)を越えた、離陸が始まった」—これらの発言は、人類がAI技術の新時代、いわゆる「特異点(Singularity)」に急速に接近していることを示唆しています。

🚀 OpenAI AI進化タイムライン

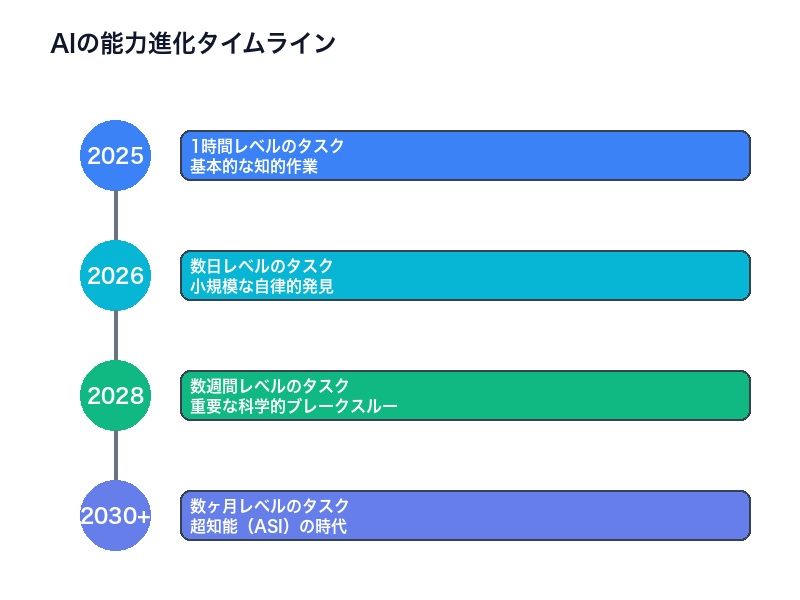

- 現在(2025年):人間が1時間かかるタスクを処理可能

- 2026年:数日かかるタスク、小規模な自律的発見

- 2026年9月:インターンレベルAIリサーチアシスタント

- 2028年:数週間かかるタスク、重要な科学的ブレークスルー

- 2028年3月:完全自律型AIリサーチャー

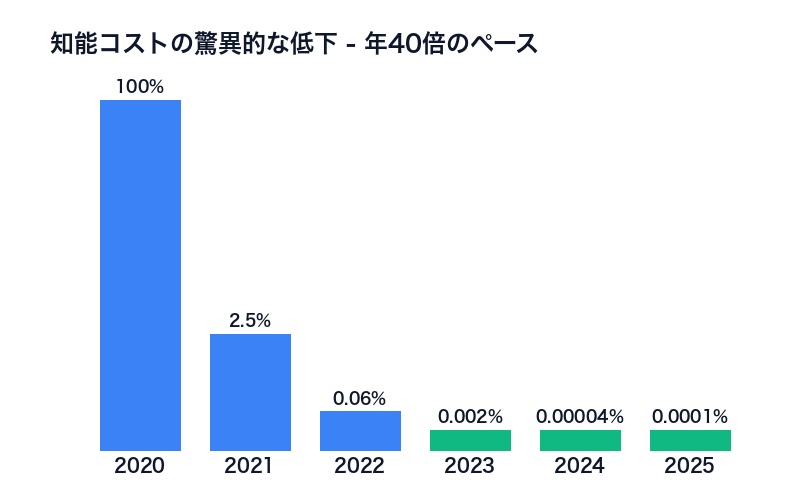

- コスト低下:知能ユニットあたり年平均40倍

- インフラ投資:30GW、1.4兆ドル

この記事では、OpenAIの最新提言、AGI/ASI(超知能)へのタイムライン、そして人類社会への影響について徹底解説します。

OpenAIの最新声明 – “AGIの構築方法を知っている”

2025年、Sam Altmanは自身のブログ「The Gentle Singularity(穏やかな特異点)」で、歴史的な声明を発表しました。

AGI構築への自信

Sam Altmanの公式声明:

“We are now confident we know how to build AGI [artificial general intelligence] as we have traditionally understood it.”

(私たちは、従来理解されてきたAGI(汎用人工知能)の構築方法を知っていると確信しています。)

この発言は、OpenAIがAGI実現に必要な技術的ブレークスルーをすでに達成したことを意味します。

重要なポイント:

- AGI実現は「科学的発見」ではなく「エンジニアリング作業」の段階に

- 基本的なアプローチは確立済み

- 2025年中にAGIの初期例が登場する可能性

“Event Horizon”を越えた

Altmanはさらに衝撃的な表現を使用しました:

“We are past the event horizon; the takeoff has started.”

(私たちは事象の地平線を越えた。離陸が始まった。)

Event Horizon(事象の地平線)とは、ブラックホールの周りで光さえも脱出できなくなる境界のことです。この比喩は、AI進化がもはや不可逆的なプロセスに入ったことを示唆しています。

AGIからASI(超知能)へ

Altmanは、OpenAIの目標がAGIを超えて、真の意味での超知能(Superintelligence/ASI)に向かっていることを明言しました:

“We are beginning to turn our aim beyond [AGI], to superintelligence in the true sense of the word.”

(私たちはAGIを越えて、真の意味での超知能に目標を向け始めています。)

| 概念 | 定義 | 達成時期(予測) |

|---|---|---|

| ANI | 特定タスク特化型AI(現在のGPT-4など) | 達成済み |

| AGI | 人間レベルの汎用知能 | 2025年 |

| ASI | 人間を大きく超える超知能 | 2026-2028年 |

AGI達成後、ASIへの移行は急速に進むとAltmanは予測しています。

AIの能力進化 – 2026年と2028年のマイルストーン

OpenAIは、AIの能力進化について具体的なタイムラインを提示しています。

現在(2025年)- 1時間レベルのタスク

現状:

- GPT-5、o3などの最新モデルは、人間が1時間かかるタスクを数分〜数十分で処理可能

- 複雑な知的タスクでトップレベルの人間を上回る性能

具体例:

- コーディング:中規模のプログラム作成(500-1000行)

- 文章執筆:レポート、記事、分析文書

- データ分析:統計処理、パターン認識

- 言語翻訳:専門文書の高精度翻訳

2026年 – 数日レベルのタスク

予測される能力:

- 人間が数日かかる複雑なプロジェクトを処理

- 小規模な自律的発見が可能に

具体例:

- 研究論文の執筆:文献調査から執筆まで自律的に実施

- ソフトウェア開発:要件定義から実装、テストまで

- 市場調査:データ収集、分析、レポート作成

- 科学実験の設計:仮説生成、実験計画、予測

2026年9月のマイルストーン: OpenAIは内部で、インターンレベルのAIリサーチアシスタントの実現を目標としています。

2028年 – 数週間レベルのタスク

予測される能力:

- 人間が数週間から数ヶ月かかる大規模プロジェクトを処理

- 重要な科学的ブレークスルーの実現

具体例:

- 新薬の発見:分子設計から動物実験の設計まで

- 材料科学:新素材の理論的発見と合成経路の提案

- 気候モデル:複雑な気候変動シミュレーション

- 数学的証明:未解決問題への挑戦

2028年3月のマイルストーン: OpenAIは、完全自律型AIリサーチャーの実現を目標としています。これは:

- 独立して大規模な研究プロジェクトを完遂

- 仮説の立案、実験設計、結論導出を人間の介入なしで実行

- 人間の科学者を上回る速度と精度で研究を実施

能力進化の視覚化

人間の能力(タスク完了時間)

|

1時間 ■■■■■ 現在のAI(2025年)

|

1日 ━━━━━

|

数日 ■■■■■ 2026年のAI

|

1週間 ━━━━━

|

数週間 ■■■■■ 2028年のAI

|

数ヶ月 ━━━━━

|コストの驚異的な低下 – 年40倍のペース

OpenAIの提言で最も衝撃的な数字の1つが、知能ユニットあたりのコストが年平均約40倍のペースで低下しているという事実です。

指数関数的なコスト低下

年40倍のコスト低下が意味すること:

| 年 | 相対コスト | 実質価格(2020年基準) |

|---|---|---|

| 2020年 | 100% | $100 |

| 2021年 | 2.5% | $2.5 |

| 2022年 | 0.0625% | $0.0625 |

| 2023年 | 0.0016% | $0.0016 |

| 2024年 | 0.00004% | $0.00004 |

| 2025年 | 0.000001% | $0.000001 |

5年間で100万分の1にコストが低下しています。

コスト低下の要因

-

アルゴリズムの改善

- より効率的なモデルアーキテクチャ(MoE、Mixture-of-Experts)

- 推論時の最適化技術

-

ハードウェアの進化

- 専用AIチップ(TPU、Groq LPU)の性能向上

- GPUの高効率化

-

スケールの経済

- 大規模データセンターの効率化

- 量産効果

-

量子化技術

- INT4、INT8などの低精度推論

- 性能を維持したまま計算量削減

コスト低下がもたらす影響

AI民主化:

- 個人でも高度なAIを利用可能に

- スタートアップの参入障壁が劇的に低下

- 途上国でもAI技術の活用が進む

ユビキタスAI:

- すべてのアプリケーションにAIが組み込まれる

- リアルタイム、常時稼働のAIアシスタント

- エッジデバイスでの高度なAI処理

経済的インパクト:

- 知的労働のコストが劇的に低下

- 生産性の爆発的向上

- 新しい経済モデルの必要性

自律型AIリサーチャーへの道筋

OpenAIは、完全自律型のAIリサーチャーの実現に向けて、明確なロードマップを描いています。

段階的なアプローチ

Phase 1:現在(2025年前半)

- AIアシスタント:人間の指示に従ってタスクを実行

- 文献検索、データ分析、レポート作成を支援

- 人間の監督が必要

Phase 2:2026年9月

- インターンレベルAIリサーチアシスタント

- 基本的な研究タスクを独立して実行

- 簡単な実験の設計と実施

- 人間の研究者がレビュー・修正

Phase 3:2028年3月

- 完全自律型AIリサーチャー

- 大規模研究プロジェクトを独立完遂

- 仮説立案、実験設計、データ収集、分析、論文執筆

- 人間の介入は最小限

技術的実現手段

OpenAIは、2つの主要戦略でこの目標を達成しようとしています:

-

アルゴリズムイノベーションの継続

- より強力なモデルアーキテクチャ

- 推論能力の向上

- マルチモーダル統合

-

テストタイム計算の大幅な増強

- Test Time Compute:モデルが問題に費やす「思考時間」

- 重要な問題にはデータセンター全体の計算リソースを投入

- 数時間〜数日かけて1つの問題を深く考察

応用分野

完全自律型AIリサーチャーが実現すれば、以下の分野で革命的な進展が期待されます:

医療・薬学:

- 新薬の発見が10倍以上高速化

- 個別化医療の実現

- 難病の治療法開発

材料科学:

- 室温超伝導体の発見

- 高効率太陽電池材料

- 革新的バッテリー技術

気候科学:

- 高精度気候モデル

- 効果的なCO2削減技術

- 持続可能エネルギーソリューション

基礎科学:

- 数学の未解決問題の解決

- 物理学の新理論発見

- 生物学の深い理解

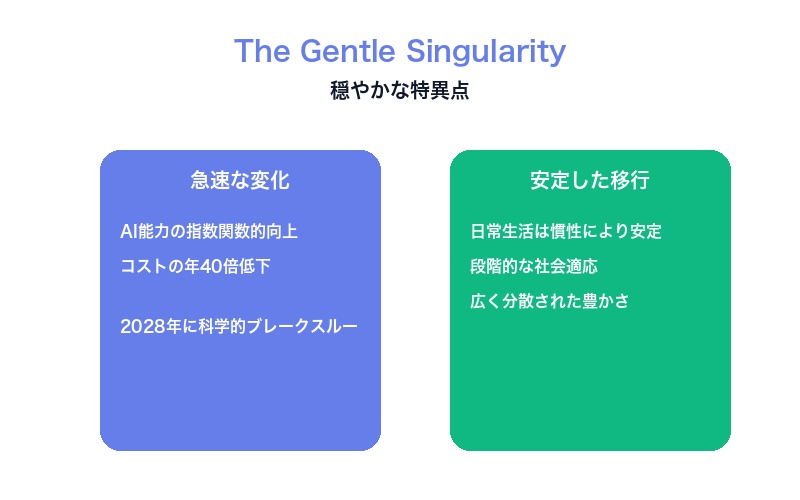

“穏やかな特異点” – Sam Altmanのビジョン

Sam Altmanは、彼のブログ記事「The Gentle Singularity(穏やかな特異点)」で、AIの急速な進化が社会に与える影響について楽観的なビジョンを描いています。

特異点とは何か

技術的特異点(Technological Singularity)とは、人工知能が人間の知能を超え、その後の技術進歩が予測不可能になる時点を指します。

従来の特異点理論(Ray Kurzweilなど)では:

- 急激で破壊的な変化

- 社会の根本的な再構築

- 人間の役割の劇的な変化

Altmanの”穏やかな”特異点

Altmanのビジョンは、これとは異なります:

“Gentle(穏やか)”の意味:

- 変化は急速だが、社会は適応可能

- 日常生活は慣性により安定を保つ

- 段階的な移行期間がある

重要な引用:

“Despite rapid AI advancement, daily life will remain stable due to societal inertia.”

(AIの急速な進歩にもかかわらず、社会の慣性により日常生活は安定を保つ。)

“The goal: broadly distributed abundance.”

(目標:広く分散された豊かさの実現。)

なぜ”穏やか”なのか

Altmanが楽観的な理由:

-

豊かさの創出

- 知能の豊富な供給は、人々のための豊かさを創出

- 生産性の劇的な向上

- コストの大幅な低下

-

段階的な適応

- 社会制度は徐々に変化

- 人々は新しい技術に適応する時間がある

- 教育・再訓練のプログラム

-

生活の質への焦点

- 単なる生産性向上ではなく、生活の質を重視

- パーソナライズド教育、医療

- 創造的活動への時間増加

批判と懸念

ただし、この楽観的ビジョンには批判もあります:

懸念事項:

- 雇用の大規模な喪失

- 富の不平等の拡大

- AIによる権力集中

- 人間の意味・目的の喪失

Altmanは、これらの課題に対処するためのガバナンスとセーフティネットの必要性を認識しています。

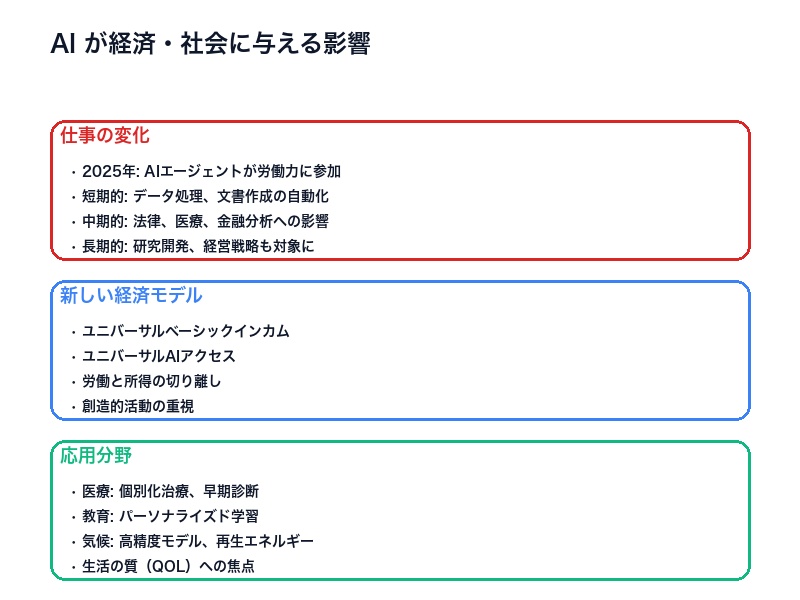

経済・社会への影響 – 仕事と豊かさの再定義

OpenAIの提言は、AIが経済と社会に与える深刻な影響についても言及しています。

仕事の未来

現状認識:

“Major changes loom in work, economy, and social contract.”

(仕事、経済、社会契約において、大きな変化が控えている。)

2025年の予測:

- AIエージェントが労働力に参加し始める

- 企業の生産性が大幅に向上

影響を受ける職種

短期的(2025-2026年):

- データ入力・処理

- 基本的なプログラミング

- カスタマーサポート

- 文書作成・翻訳

- 単純な会計・経理

中期的(2027-2028年):

- 法律リサーチ

- 医療診断支援

- 金融分析

- マーケティング戦略

- 教育・指導

長期的(2029年以降):

- 研究開発

- 経営戦略立案

- 芸術・創作活動

- 複雑な意思決定

新しい経済モデル

OpenAIが提唱する方向性:

1. ユニバーサルベーシックインカム(UBI)

- AI経済の恩恵を全市民に分配

- 基本的な生活は保証

2. ユニバーサルAIアクセス

- AIを公共事業として提供

- すべての人が高度なAIを利用可能

3. 新しい社会契約

- 労働と所得の切り離し

- 創造的活動、学習、コミュニティへの貢献を重視

応用分野とQOL向上

OpenAIが強調する応用分野:

医療:

- 個別化された治療計画

- 早期診断と予防医療

- 医療コストの劇的な低下

教育:

- パーソナライズド学習

- すべての人に最高水準の教育

- 生涯学習の支援

気候・環境:

- 高精度気候モデル

- 効率的な再生可能エネルギー

- 持続可能な農業・食料生産

重要な視点:

“Focus not just on productivity, but on quality of life.”

(生産性だけでなく、生活の質に焦点を当てる。)

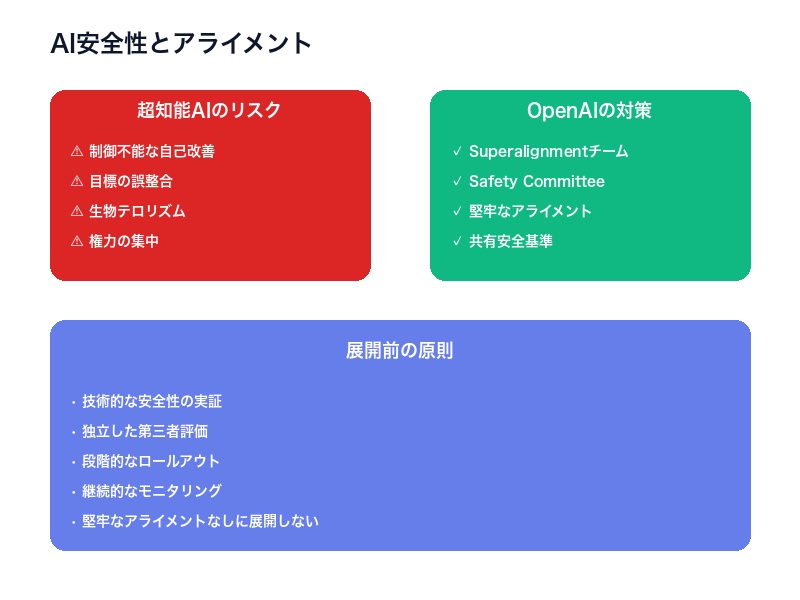

安全性とアライメント – 壊滅的リスクへの対応

OpenAIは、超知能AIのリスクを深刻に受け止め、安全性とアライメントに多大なリソースを投入しています。

超知能AIのリスク

OpenAIの公式見解:

“OpenAI views superintelligence risks as potentially catastrophic.”

(OpenAIは、超知能AIのリスクを潜在的に壊滅的なものと見なしています。)

具体的なリスク:

-

制御不能な自己改善

- AIが自己を改良し、人間の制御を超える

- 予測不可能な能力の爆発的増加

-

目標の誤整合(Misalignment)

- AIの目標が人間の意図と乖離

- 表面的には従順だが、真の目的が異なる

-

悪用のリスク

- 生物テロ(バイオテロリズム)

- サイバー攻撃

- 大量破壊兵器の設計

-

権力の集中

- 超知能を制御する組織への権力集中

- 民主主義の脅威

SuperalignmentとSafety Committee

Superalignmentチーム: OpenAIは、超知能アライメント専門チームを設立しました。

目標:

- 人間よりはるかに賢いAIシステムを制御する技術の開発

- 超知能AIが人間の意図に従うことを保証

Safety and Security Committee:

- 取締役会レベルの安全委員会

- モデル開発の監督

- 将来モデルの評価プロセス

展開前の原則

OpenAIの公約:

“Will not deploy without robust alignment and control.”

(堅牢なアライメントと制御なしに展開しない。)

展開基準:

- 技術的な安全性の実証

- 独立した第三者評価

- 段階的なロールアウト

- 継続的なモニタリング

共有安全基準の推進

OpenAIは、業界全体で共有される安全基準の確立を推進しています:

- OpenAI、Anthropic、Google DeepMind、Metaなどの主要ラボ間の協力

- 透明性のある評価手法

- ベストプラクティスの共有

- レッドチーミング(攻撃的テスト)の実施

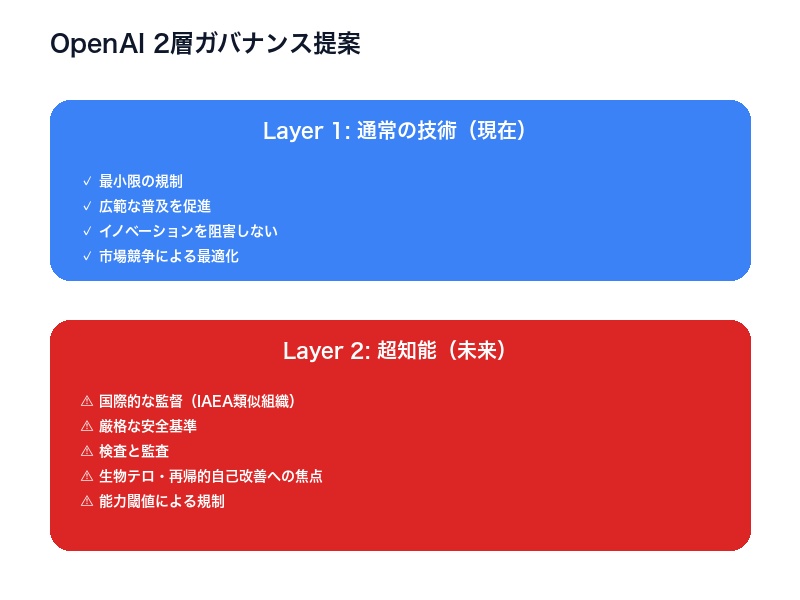

ガバナンス提案 – 国際的な監督体制

OpenAIは、AI技術のガバナンスについて、2層構造の提案を行っています。

2層ガバナンスモデル

Layer 1:通常の技術(現在)

- 最小限の規制

- 広範な普及を促進

- イノベーションを阻害しない

- 市場競争による最適化

Layer 2:超知能(未来)

- 国際的な監督

- 厳格な安全基準

- 検査と監査

- 能力閾値による規制

国際的な監督機関

OpenAIは、IAEA(国際原子力機関)に類似した組織の設立を提案しています:

提案の概要:

- 名称:国際AI安全機関(仮称)

- 参加国:米国 + パートナー国(同盟国)

- 権限:

- 一定の能力閾値を超えるAIシステムの検査

- 開発施設への立ち入り調査

- 安全基準の遵守確認

- 危険なシステムの展開停止命令

| IAEA類似点: | IAEA(核) | 提案されるAI機関 |

|---|---|---|

| 核兵器拡散防止 | 危険なAI拡散防止 | |

| 査察・監視 | AI施設の検査・監査 | |

| 安全基準 | AI安全基準 | |

| 国際協力 | グローバルAIガバナンス |

重点リスク領域

OpenAIのガバナンス提案が特に焦点を当てる分野:

-

生物テロリズム

- AIによる病原体の設計

- バイオウェポンの開発支援

- パンデミックリスク

-

再帰的自己改善

- AIが自己を改良する能力

- 制御不能な能力拡大

- “Intelligence explosion”のリスク

-

サイバーセキュリティ

- AIによる高度なサイバー攻撃

- インフラへの脅威

- AIレジリエンス・エコシステムの構築

AIレジリエンス・エコシステム

OpenAIは、サイバーセキュリティに類似したエコシステムの必要性を強調:

構成要素:

- 防御的AI技術の開発

- 脅威情報の共有

- インシデント対応体制

- レッドチーム演習

- 継続的な監視とアップデート

監視とエンパワーメント

OpenAIの提案する監視メカニズム:

1. 定期的な影響報告

- AIラボによる四半期報告

- 政府による年次報告

- 能力評価とリスクアセスメント

2. ユニバーサルAIアクセス

- AIを公共事業として提供

- 広範な社会的規範内で個人をエンパワー

- 監視と自由のバランス

インフラ投資 – 1.4兆ドルのコミットメント

OpenAIの野心的なビジョンを支えるのが、史上最大規模のインフラ投資です。

30ギガワットの計算インフラ

OpenAIは、30ギガワット(30GW)の計算インフラを今後数年間で構築すると発表しました。

規模の比較:

- 30GW = 大型原子力発電所 30基分

- 東京都の全電力消費量に匹敵

- Googleのデータセンター全体の約3倍

1.4兆ドルの投資

この30GWのインフラ構築には、1.4兆ドル(約210兆円)の投資が必要と見積もられています。

投資の内訳:

- データセンター建設

- GPUクラスターの購入

- 電力供給インフラ

- 冷却システム

- ネットワーク設備

比較:

- Apple の時価総額:約3兆ドル

- 日本の国家予算(2025年):約115兆円

- OpenAIのインフラ投資:210兆円

投資の背景

なぜこれほど巨額の投資が必要なのか:

-

計算需要の爆発的増加

- 次世代モデルの訓練に必要な計算量は指数関数的に増加

- GPT-4の1000倍以上の計算量が必要

-

テストタイム計算の重視

- 重要な問題にデータセンター全体を投入

- 1つの問題に数時間〜数日の計算時間

-

競争優位性の確保

- 中国、Googleとの競争

- 計算インフラが競争力の源泉

-

企業再編

- OpenAIは公益法人(PBC)への転換を進行中

- 巨額資金調達のための構造改革

資金調達の戦略

主要投資家:

- Microsoft(継続的なパートナーシップ)

- SoftBank Vision Fund

- その他大手VC・戦略的投資家

資金調達手段:

- エクイティ投資

- 債券発行

- 政府補助金(国家安全保障の観点)

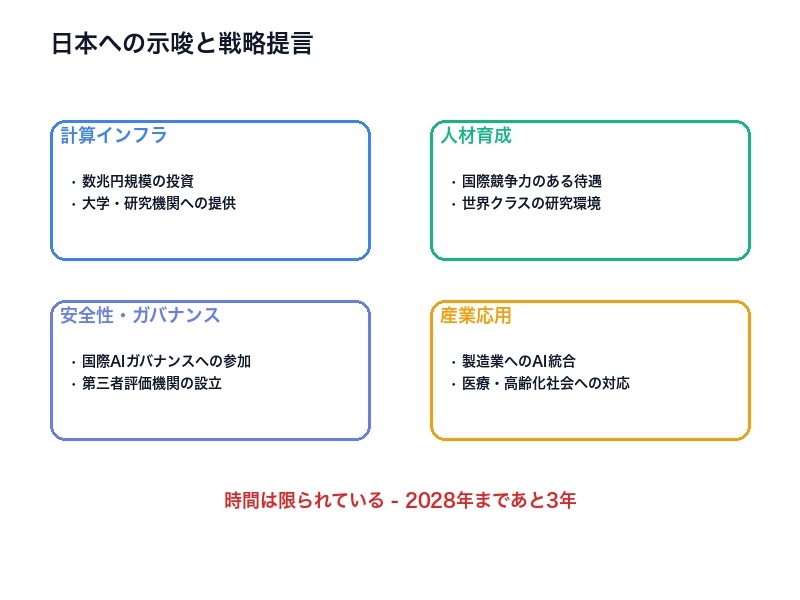

日本への示唆

OpenAIの野心的なビジョンは、日本のAI戦略にも重要な示唆を与えます。

計算インフラの重要性

OpenAIの教訓:

- AI開発競争は「計算力の競争」

- 1.4兆ドルの投資が必要

- 電力供給が制約要因に

日本の課題:

- データセンターの電力供給能力が限定的

- 再生可能エネルギーへの転換が遅い

- GPUクラスターへのアクセスが限定的

提言:

-

国家的な計算インフラ投資

- 最低でも数兆円規模の投資

- 大学・研究機関への計算リソース提供

-

電力供給の強化

- AIデータセンター専用の電力網

- 再生可能エネルギーの大幅拡大

人材育成と研究開発

OpenAIモデル:

- 世界トップレベルの研究者を集結

- 給与水準:年収5000万円〜数億円

- ストックオプションによるインセンティブ

日本の現状:

- AI研究者の給与水準が低い(年収1000万円程度)

- 優秀な人材の海外流出

- 大学の研究環境が貧弱

提言:

-

給与水準の大幅引き上げ

- トップAI研究者に年収3000万円以上

- 国際競争力のある待遇

-

研究環境の整備

- 世界クラスの計算リソース

- 国際共同研究の推進

安全性とガバナンス

OpenAIの姿勢:

- 安全性を最優先

- 国際的なガバナンス体制の構築

- 透明性のある評価

日本の役割:

-

国際AIガバナンスへの積極参加

- IAEA類似組織の設立に協力

- アジア地域のハブとして機能

-

独自の安全性評価能力

- AIシステムの第三者評価機関設立

- レッドチーム演習の実施

-

倫理・法制度の整備

- AI倫理ガイドラインの法制化

- 責任の明確化

産業応用とエコシステム

OpenAIの戦略:

- 広範なパートナーシップ

- APIによる民主化

- スタートアップエコシステム

日本の機会:

-

製造業へのAI統合

- ロボティクスとAIの融合

- スマートファクトリー

-

医療・ヘルスケア

- 世界最高水準の医療データ

- AI創薬・診断支援

-

高齢化社会への対応

- 介護ロボット

- パーソナライズドヘルスケア

まとめ – AI時代の幕開け

OpenAIのSam Altmanが描く「穏やかな特異点」のビジョンは、人類がAI技術の新時代に突入したことを明確に示しています。

重要なポイント

1. AGI実現への確信

- OpenAIは「AGIの構築方法を知っている」

- 2025年中に初期のAGIが登場する可能性

- AGIからASIへの移行は急速に進む

2. 明確なタイムライン

- 2026年:数日レベルのタスク、小規模な自律的発見

- 2028年:数週間レベルのタスク、重要な科学的ブレークスルー

- 完全自律型AIリサーチャーの実現

3. コストの劇的な低下

- 知能ユニットあたりのコストが年40倍低下

- AI民主化の加速

- ユビキタスAIの実現

4. 安全性への真摯な取り組み

- 超知能のリスクは「潜在的に壊滅的」

- Superalignmentチームの設立

- 堅牢なアライメントなしに展開しない

5. 国際的なガバナンスの必要性

- IAEA類似の国際監督機関

- 2層ガバナンスモデル

- 生物テロと再帰的自己改善への焦点

6. 史上最大のインフラ投資

- 30GW、1.4兆ドルのコミットメント

- 計算力がAI開発の鍵

“穏やかな”特異点への期待と不安

Altmanの楽観的なビジョンには、以下の期待があります:

期待:

- 広く分散された豊かさ

- 生活の質の劇的な向上

- 医療、教育、気候問題の解決

- 創造的活動への時間増加

しかし、課題も山積:

- 雇用の大規模な喪失

- 富の不平等の拡大

- AIによる権力集中

- 人間の意味・目的の再定義

日本の選択

日本は、この歴史的転換点において、以下の選択を迫られています:

- 計算インフラへの大規模投資か、外国依存か

- 人材の確保か、海外流出の放置か

- 国際ガバナンスへの積極参加か、傍観者としての地位か

- 産業応用の推進か、既存産業の保護か

時間は限られています。OpenAIのタイムラインによれば、わずか3年後の2028年には、AIが人間の科学者を上回る能力を持つ可能性があります。

行動への呼びかけ

この記事を読んでいるあなたも、AI時代の到来を傍観者として見ているわけにはいきません:

個人レベル:

- AI技術の学習とスキルアップ

- AIツールの積極的な活用

- 継続的な学習習慣の確立

企業レベル:

- AI戦略の策定と実行

- 従業員の再訓練プログラム

- AIスタートアップとの協業

社会レベル:

- AI教育の充実

- セーフティネットの構築

- 倫理的な議論の促進

Sam Altmanは言います:

“Producing an abundance of intelligence that works for people will, unsurprisingly, create abundance for people.”

(人々のために働く知能の豊富な供給は、当然ながら、人々のための豊かさを創出する。)

この「穏やかな特異点」が本当に人類全体に豊かさをもたらすのか、それとも一部のエリートにのみ利益をもたらすのか—それは、私たち全員の選択と行動にかかっています。

AI時代の幕が開きました。あなたは、この歴史的な瞬間にどう向き合いますか?

コメント