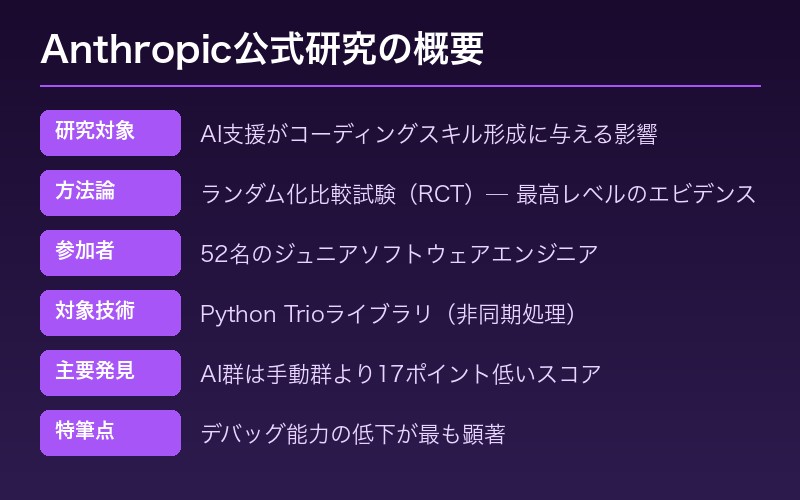

Anthropicが自社でAIのリスクを科学的に証明

2026年1月29日、AIセーフティ企業Anthropicが衝撃的な研究論文を発表した。自社のAIアシスタント「Claude」の開発元が、AIコーディング支援がプログラマーのスキル形成を阻害する可能性を科学的に証明したのだ。

研究タイトルは「How AI assistance impacts the formation of coding skills(AI支援がコーディングスキル形成に与える影響)」。著者はJudy Hanwen ShenとAlex Tamkinの両研究者で、arXivにも論文が公開されている。

注目すべきは、Claude開発元であるAnthropicが自社製品のリスクを正面から検証している点だ。「AIは便利だが、使い方を誤るとスキルが育たない」という警告は、AI推進派からの発信だからこそ重みがある。

研究方法:52人のエンジニアによるRCT試験

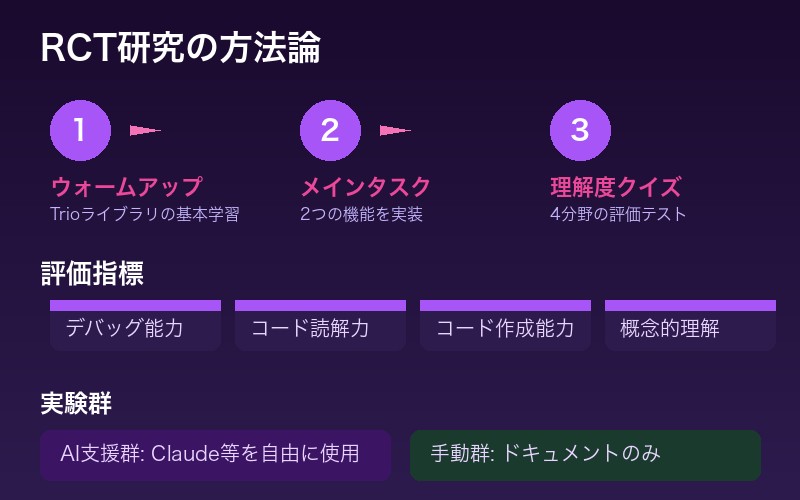

本研究は、医学研究で使用されるランダム化比較試験(RCT)を採用。これは「エビデンスの質」として最高レベルとされる研究手法だ。

| 項目 | 詳細 |

|---|---|

| 参加者 | 52名(主にジュニアソフトウェアエンジニア) |

| 対象技術 | Python「Trio」ライブラリ(非同期処理) |

| 実験設計 | AI支援群 vs 手動コーディング群 |

| タスク構成 | ウォームアップ → 機能実装2つ → 理解度クイズ |

| 評価指標 | デバッグ能力、コード読解力、コード作成能力、概念的理解 |

参加者は「Trio」という未経験のライブラリを学習。AI群はClaudeなどのAIアシスタントを自由に使用でき、対照群は従来のドキュメントやStack Overflowのみを使用した。

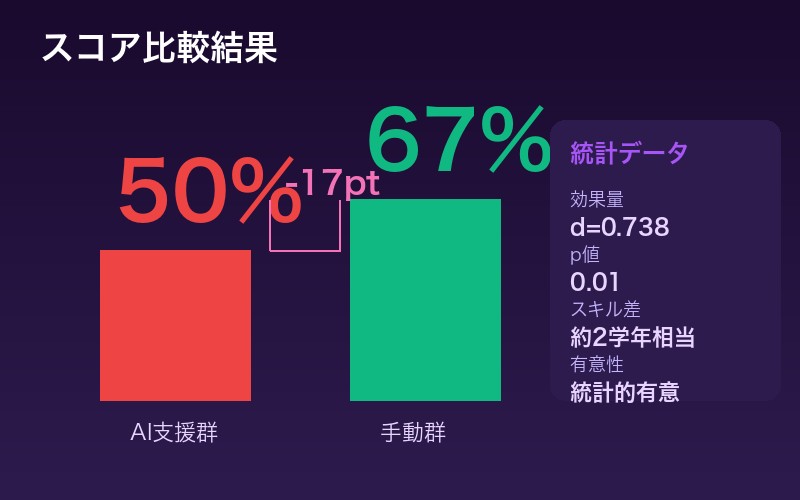

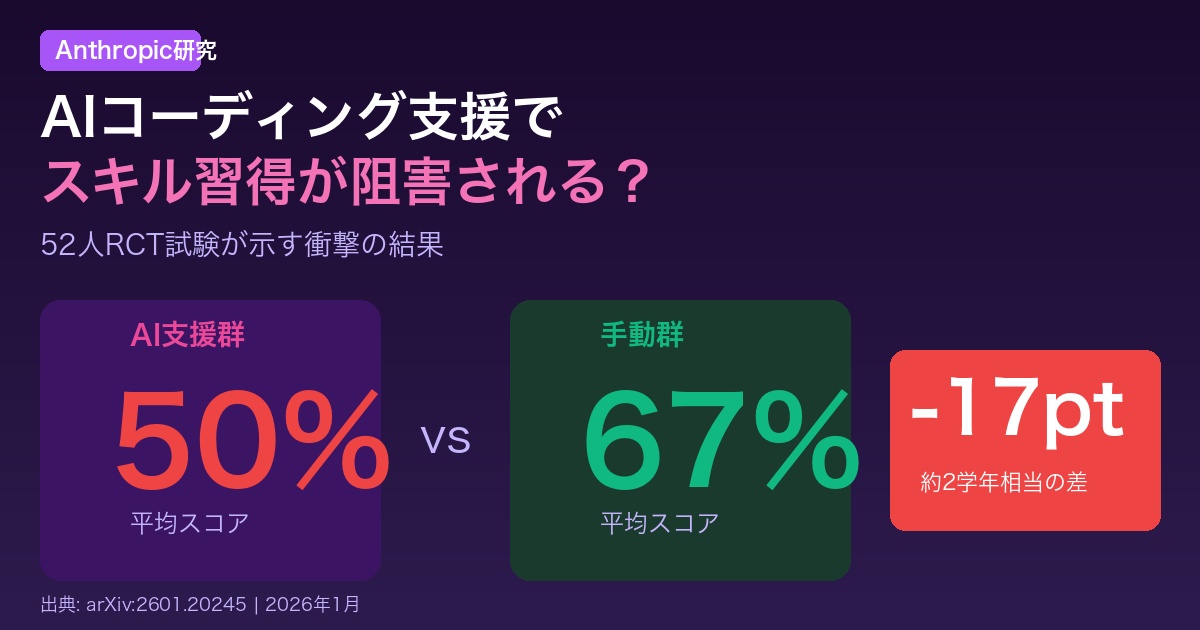

衝撃の結果:AI群は17ポイント低いスコア

研究結果は多くの開発者にとって衝撃的なものとなった。

| 指標 | AI支援群 | 手動群 | 差 |

|---|---|---|---|

| 平均スコア | 50% | 67% | -17ポイント |

| 効果量(Cohen’s d) | 0.738 | 大きな効果 | |

| 統計的有意性 | p = 0.01 | 有意 | |

| スキル差換算 | 約2学年相当 | ||

17ポイントの差は、統計的に「約2学年相当」のスキル差に相当する。つまり、AIを使ってコーディングを学んだエンジニアは、手動で学んだエンジニアより2年遅れのスキルレベルになるリスクがあるということだ。

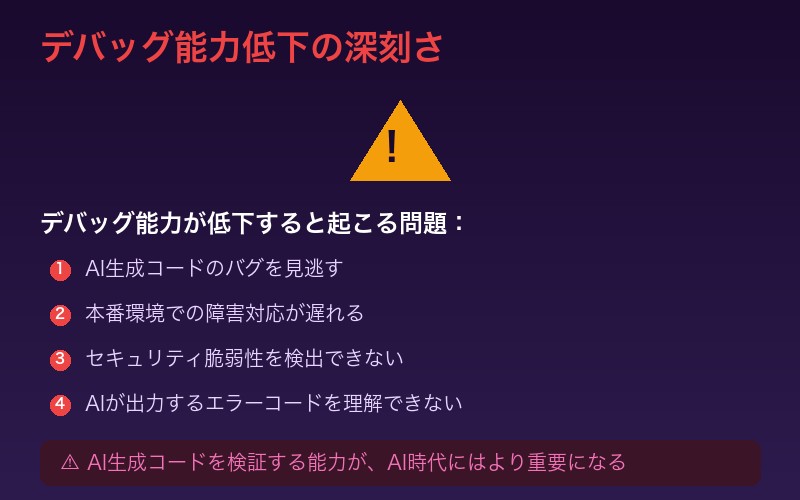

最大の問題:デバッグ能力の低下

研究で特に深刻とされたのが、デバッグ能力の大幅な低下だ。

デバッグとは、コードのエラーを発見し、原因を特定し、修正する能力のこと。この能力が低下すると:

- AI生成コードのバグを見逃す

- 本番環境での障害対応が遅れる

- セキュリティ脆弱性を検出できない

- AIが出力するエラーコードを理解できない

研究者は「AIがコードを生成する時代だからこそ、AIの出力を検証できる能力が重要になる」と警告している。AI生成コードを「そのまま使う」エンジニアが増えると、システム全体の品質低下につながる可能性がある。

AI使用パターンの分析:学習効果を左右する6つのタイプ

研究チームは、AI群の参加者がどのようにAIを使用したかを詳細に分析。使い方によって学習効果が大きく異なることを発見した。

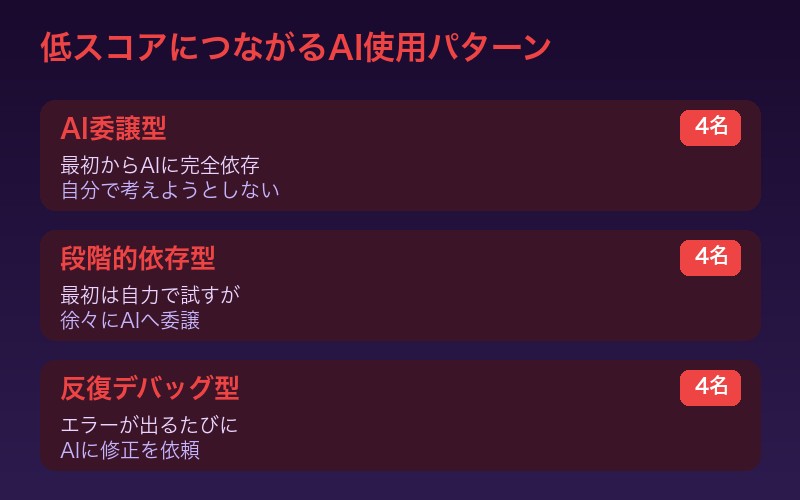

低スコアにつながるパターン(3タイプ)

| パターン | 人数 | 特徴 |

|---|---|---|

| AI委譲型 | 4名 | 最初からAIに完全依存。自分で考えようとしない |

| 段階的依存型 | 4名 | 最初は自力で試すが、徐々にAIへ委譲 |

| 反復デバッグ型 | 4名 | エラーが出るたびにAIに修正を依頼 |

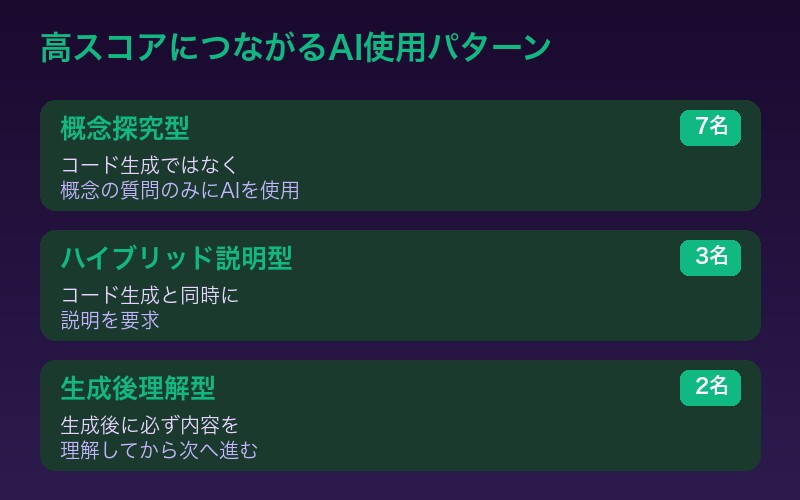

高スコアにつながるパターン(3タイプ)

| パターン | 人数 | 特徴 |

|---|---|---|

| 概念探究型 | 7名 | コード生成ではなく概念の質問のみにAIを使用 |

| ハイブリッド説明型 | 3名 | コード生成と同時に説明を要求 |

| 生成後理解型 | 2名 | 生成後に必ず内容を理解してから次へ進む |

重要な発見は、「AIを使うかどうか」ではなく「どう使うか」が学習効果を決定するという点だ。概念理解にAIを活用した参加者は、手動群と同等以上のスコアを達成している。

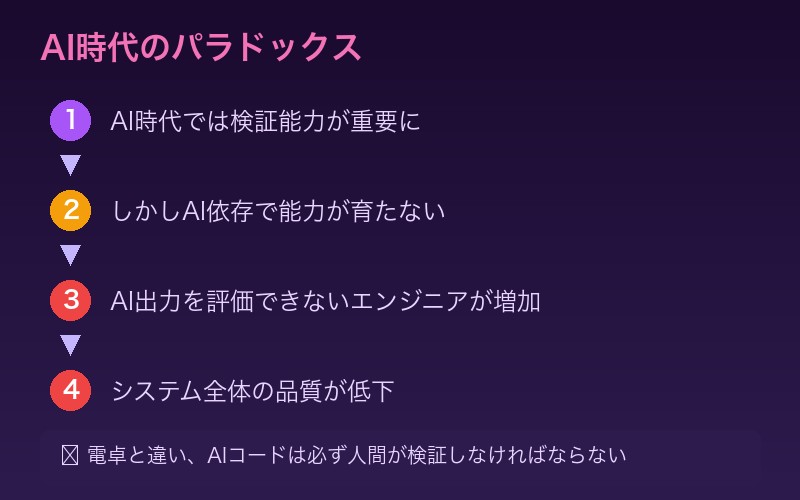

なぜこの問題が深刻なのか:AI時代の逆説

研究者は、この発見が持つ長期的な影響について警告している。

AI時代のパラドックスとは:

- AIがコードを生成する時代では、AI出力を検証する能力がより重要になる

- しかし、AIに依存して学習すると、その検証能力が育たない

- 結果として、AIの出力を正しく評価できないエンジニアが増加

- バグやセキュリティ脆弱性が見過ごされ、システム全体の品質が低下

これは「電卓の登場で暗算能力が低下した」という過去の議論とは本質的に異なる。電卓は計算結果を検証する必要がないが、AIコードは必ず人間が検証しなければならないからだ。

完了時間:生産性向上は限定的

興味深いのは、AI群の完了時間についてのデータだ。

| グループ | 完了時間 | 備考 |

|---|---|---|

| AI支援群 | 約2分短縮 | 統計的有意性なし |

| 手動群 | 基準 | – |

AI群は平均で約2分早くタスクを完了したが、この差は統計的に有意ではなかった。つまり、生産性向上のメリットは限定的な一方で、スキル低下のデメリットは大きいという結果だ。

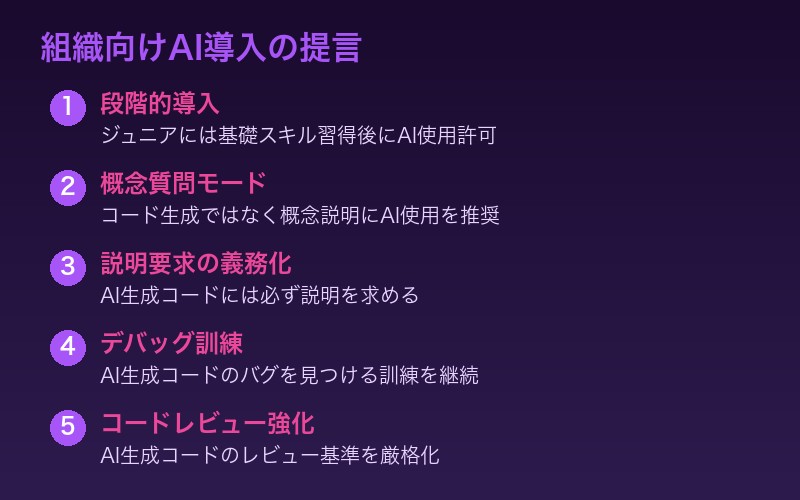

組織への提言:意図的なAI導入設計が必要

研究チームは、組織がAIコーディングツールを導入する際の具体的な提言を行っている。

推奨される導入アプローチ

| アプローチ | 説明 |

|---|---|

| 段階的導入 | ジュニアエンジニアには基礎スキル習得後にAI使用を許可 |

| 概念質問モード | コード生成ではなく概念説明にAIを使用する文化を推奨 |

| 説明要求の義務化 | AI生成コードには必ず説明を求めることをルール化 |

| デバッグ訓練 | AI生成コードのバグを意図的に見つける訓練を実施 |

| コードレビュー強化 | AI生成コードのレビュー基準を厳格化 |

研究の限界と今後の課題

研究チームは、本研究の限界も正直に認めている。

- サンプルサイズ:52名は統計的に十分だが、より大規模な追試が望ましい

- 即時測定のみ:タスク直後の理解度測定であり、長期的なスキル定着は未検証

- 単一技術:Trioライブラリのみを対象としており、他技術への一般化は要検証

- コーディング限定:設計、テスト、運用などの他タスクへの影響は未検証

今後の研究では、長期的なスキル発展の追跡や、異なる技術スタック、異なるスキルレベルのエンジニアを対象とした検証が期待される。

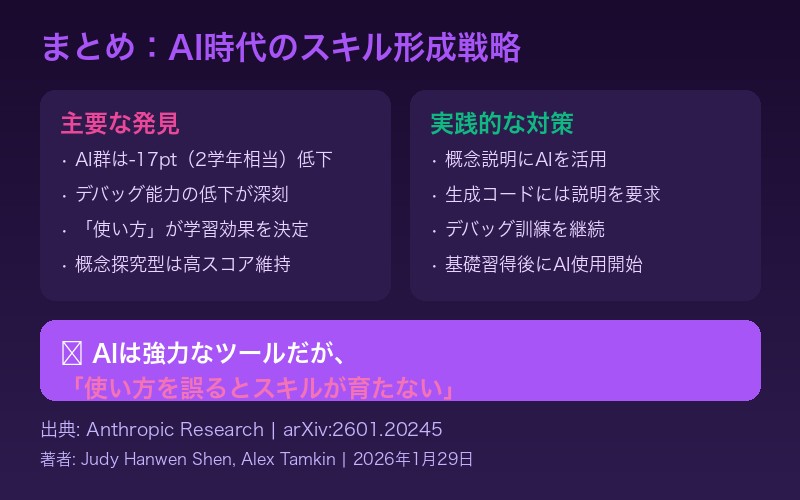

まとめ:AI時代に求められるスキル形成戦略

Anthropicの研究は、AI開発企業自身がAI依存のリスクを科学的に証明したという点で画期的だ。

主要な発見

- AI支援群は手動群より17ポイント(約2学年相当)低いスコア

- 特にデバッグ能力の低下が深刻

- AI使用自体ではなく「使い方」が学習効果を決定

- 概念理解にAIを使う人は高スコアを維持

実践的な対策

- コード生成ではなく概念説明にAIを活用

- AI生成コードには必ず説明を要求

- 意図的にデバッグ訓練を継続

- 基礎スキル習得後にAI使用を開始

AIは強力なツールだが、「使い方を誤るとスキルが育たない」という警告は、すべてのエンジニアと教育者が心に留めておくべきだろう。Anthropicの研究は、AI時代のスキル形成戦略を考える上で、重要な科学的エビデンスを提供している。

論文リンク:arXiv:2601.20245

コメント